Cosmologie/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/Cosmologie

Le paradoxe d'Olbers

Nous allons commencer ce cours avec une question simple, qui est paradoxalement une excellente introduction à la cosmologie :

- Pourquoi la nuit est-elle noire ?

Cette question peut sembler étrange, tant nous sommes habitués à voir les étoiles sur un fond noir. Bien que la lumière artificielle nous cache les étoiles et éclaire le ciel nocturne, nous savons que cette lumière cache le noir de la nuit, ses étoiles et la Lune. Mais pour un scientifique, même les choses évidentes sont dignes d'intérêt et demandent à être expliquées.

Les astronomes de l'antiquité n'étaient eux-mêmes pas surpris par l'obscurité de la nuit. Pour simplifier, ils pensaient les étoiles attachées à une sphère céleste, une sorte de sphère/coupole géante qui recouvre le ciel. S'ils supposaient que la Terre tourne sur elle-même, ils supposaient la sphère céleste fixe, expliquant le mouvement des étoiles au cours de la nuit et des saisons. Pour être plus précis, leur pensée utilisait plusieurs sphères : une pour le Soleil, une pour la Lune, une pour les étoiles proches, une pour les étoiles fixes des constellations (la plus lointaine) et bien d'autres. L'explication au noir de la nuit était que les étoiles étaient en nombre limitées et à des endroits bien précis, elles ne recouvraient pas entièrement le ciel. Beaucoup de savants avaient compris que ce modèle de sphères concentriques était un artifice de calcul utile, mais fondamentalement faux. Néanmoins, l'explication fondamentale au noir de la nuit restait valide : il n'y avait pas assez d'étoiles pour illuminer le ciel.

|

|

Avec les progrès de l'astronomie, et notamment l'arrivée des modèles géocentriques et héliocentriques, ce modèle de sphères emboîtées fût remis en cause. Pour les astronomes du moyen-âge et de la renaissance, les étoiles et astres n'étaient pas fixés sur des sphères proches, mais peuvent emplir tout l'espace. Leur vision de l'univers évolua vers un modèle d'univers infini, immobile, éternel, homogène. Par immobile, on veut dire que les effets de la gravité des astres s'annulent mutuellement sur de grandes distances. Chaque galaxie s'éloigne ou se rapproche de la nôtre, mais dans l'ensemble, ces différents mouvements se compensent et la moyenne des vitesses des galaxies est nulle. Par infini, on veut dire que l'univers a un volume infini : il n'a pas de début ni de fin, pas de frontières ou de bords, etc. Par éternel, on veut dire qu'il a un âge infini, qu'il n'a pas de début et de fin. Et par homogène, on veut dire que la répartition des étoiles est supposée globalement uniforme à grande échelle.

Mais les astronomes du moyen-âge et de la renaissance comprirent rapidement que le noir de la nuit était incompatible avec ce qu'ils savaient de l'univers.

Le paradoxe d'Olbers

modifierLe modèle d'un univers infini, immobile, éternel, homogène est assez logique, limite intuitive, mais elle entre en conflit avec le noir de la nuit. Plusieurs savant ont en effet montré qu'un tel univers devrait avoir une nuit extrêmement lumineuse, et certainement pas une nuit noire. Cela peut paraitre étonnant, mais plusieurs astronomes l'ont déduit mathématiquement ou sur la base d'arguments logiques. C'est un paradoxe, appelé paradoxe d'Olbers, nommé ainsi en l'honneur d'Olbers , un des astronomes à avoir évoqué ce paradoxe. D'autres astronomes avaient autrefois évoqué ce paradoxe, comme Thomas Digges en 1576, Johannes Kepler en 1605 ou Edmond Halley au XVIIIe siècle, mais pas aussi explicitement qu'Olbers.

Logiquement, on s'attend à ce que la nuit soit noire car les étoiles lointaines nous envoient directement moins de lumière que les étoiles proches. Après tout, la lumière émise par un objet est répartie dans toutes les directions, ce qui fait que plus un objet est lointain, moins on reçoit sa lumière. La luminosité perçue depuis la Terre diminue avec la distance, et plus précisément avec le carré de la distance. Mais il se trouve que le diamètre apparent fait de même. Le résultat est que pour une portion du ciel d'une surface bien précise, on peut mettre soit peu d'étoiles proches, soit beaucoup d'étoiles lointaines. Il se trouve que sous certaines conditions, respectées dans l'univers infini, éternel et homogène, les deux phénomènes se compensent et que la luminosité d'une portion du ciel est globalement constante.

La lumière des étoiles se déplaçant dans le vide intersidéral en ligne droite, les étoiles sont visibles depuis la Terre tant qu'il n'y a pas d'obstacle entre elles et la Terre. Or, si l'univers est infini, éternel et homogène, alors on est certain qu'en tout point du ciel, on tombera sur au moins une étoile. Si l’univers est infini, il contient une infinité d'étoiles. Et s'il existe depuis un temps infini, la lumière de toutes ces étoiles a eu le temps d'atteindre la Terre. En conséquence, le ciel devrait être éclairé par une infinité d'étoiles. La répartition homogène des étoiles assure que ces étoiles soient réparties équitablement sur la sphère céleste, ce qui fait que peu importe où on regarde de la voûte céleste, on devrait y voir une étoile à cet endroit.

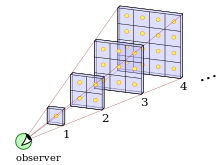

Avec ces conditions, la baisse de quantité de lumière reçue avec la distance est compensée par le plus grand nombre d'étoiles observables. Le schéma ci-contre illustre ce fait. Pour résumer, le ciel devrait être empli de lumière, cachant totalement le Soleil. C'était pour eux un paradoxe, appelé paradoxe d'Olbers, du nom de l'astronome qui le formalisa (d'autres astronomes, comme Kepler, avaient cependant mentionné ce paradoxe dans certains écrits, mais pas aussi explicitement qu'Olbers).

Pour mieux comprendre le problème, nous allons reprendre un développement mathématique assez connu qui formalise l'argument d'Olbers.

Modélisation de la répartition des étoiles

modifierEn premier lieu, on découpe l'univers en sphères concentriques. Chaque couche, chaque sphère, a une épaisseur égale à la distance moyenne entre deux étoiles. De plus, chaque couche est à une distance de la Terre.

Calcul du nombre d'étoile dans chaque couche

modifierEn second lieu, on calcule le nombre d'étoiles présentes dans chaque "sphère", dans chaque coque.

Pour cela, on utilise l'hypothèse suivante :

- H1 : Les étoiles sont uniformément réparties.

Cette hypothèse dit que la densité d'étoile, à savoir le nombre d'étoiles par unité de volume, est constante. Dans ce qui suit, nous allons la noter .

Chaque "sphère", chaque coque, contient un nombre d'étoile égal à son volume multiplié par :

Le volume d'une coque est approximativement égal à sa surface S multipliée par son épaisseur (la distance moyenne entre deux étoiles, notée D), ce qui donne :

En combinant les deux équations précédentes, on a :

Calcul du flux de lumière émis par les étoiles d'une couche

modifierEn troisième lieu, on calcule le flux de lumière émis par une couche.

Pour cela, on part de l'hypothèse suivante :

- H2 : Toutes les étoiles ont la même luminosité L.

On va utiliser cette hypothèse pour calculer le flux de lumière de chaque étoile. La physique du rayonnement nous dit que ce flux est égal à :

Le flux émis par toutes les étoiles d'une couche est la somme des flux de chaque étoile de la couche :

On utilise alors l'équation , démontrée plus haut :

On simplifie :

Cette équation nous dit que toutes les couches émettent la même quantité de lumière, ce qui n'est pas intuitif...

Calcul de la luminosité du ciel

modifierEn quatrième lieu, on combine la luminosité de toutes les couches pour trouver la luminosité totale du ciel.

Pour cela, on utilise les hypothèses suivantes :

- H3 : Toutes les étoiles sont visibles depuis la Terre, il n'y a pas d'obstacle entre une étoile et la Terre.

Cela signifie qu'il faut prendre en compte toutes les couches dans le calculs.

- H4 : L'univers est infini.

Le fait que l'univers est infini nous dit qu'il existe une infinité de couches concentriques.

- H4 : L'univers est éternel.

Le fait que l'univers est éternel nous dit que la lumière de toutes les étoiles a eu le temps d'atteindre la Terre.

Il faut donc additionner la luminosité de toutes les couches existantes pour trouver le flux de lumière visible dans le ciel, en faisant une intégrale. Nous n'allons pas faire le calcul, car il se trouve qu'on obtient un résultat infini. Intuitivement, la troisième étape suffit à comprendre pourquoi : chaque couche a une luminosité finie et identique à celle des autres couches, et il y a une infinité de couches. Le ciel devrait être infiniment lumineux !

Les "solutions" du paradoxe d'Olbers

modifierDivers savants se sont écharpés sur le paradoxe d'Olbers et de nombreuses réponses y ont été apportées. La démonstration d'Olbers n'ayant pas de problèmes mathématiques particuliers, il fallut se rendre à l'évidence : certaines hypothèses utilisées dans la démonstration sont fausses. Reste à trouver lesquelles.

On peut remettre en cause l'hypothèse de la luminosité fixe des étoiles, mais cela ne mène à rien. Même en supposant que certaines étoiles émettent peu ou pas de lumière, on se retrouve quand même avec une somme infinie.

Remettre en cause la répartition des étoiles a été envisagé, notamment dans des théories qui supposaient que la répartition des étoiles/galaxies était une distribution fractale. Ces théories sont cependant restées au stade de théories irréalistes, dont l'utilité est de montrer que telle piste de recherche est envisageable. La raison à cela est que les résultats empiriques ne suivent pas : dans ces théories, on devrait avoir des endroits du ciel qui seraient extrêmement lumineux, bien plus que le Soleil. Les observations astronomiques montrent de plus que si l'univers est assez hétérogène à petite distance, il est fortement homogène à grande distance.

Une première possibilité "crédible" était que les étoiles lointaines ne sont pas visibles depuis la Terre. Leur lumière est bien émise mais n'arrive pas à destination, reste à en trouver la raison. Une première explication fût que la lumière était absorbée par des nuages de gaz, de poussière, ou tout autre obstacle entre les étoiles et la Terre. Mais cette explication était incorrecte. L'obstacle en question absorbe le rayonnement de l'étoile, ce qui le chauffe. Or, tout corps chauffé émet un rayonnement dit de corps noir, dont l'intensité augmente avec la température. À force de chauffer, l'obstacle atteint une température d'équilibre, où le rayonnement absorbé par l'obstacle est intégralement réémis vers la Terre. L'obstacle est alors aussi lumineux que l'étoile qui le chauffe. Retour à la case départ.

La seule solution est que l'univers n'est pas infini et/ou qu'il a un âge fini. Les deux solutions font que l'on ne doit additionner que les couches les plus proches de la Terre, situées en-dessous d'un rayon maximal .

- Si l'univers a un volume fini, il a de de facto un rayon maximal .

- S'il a un âge fini , la lumière des étoiles très éloignées n'a pas eu le temps d'arriver sur Terre. Au-delà de la distance ( est la vitesse de la lumière), la lumière n'a pas encore pu arriver jusqu’à la Terre.

Le décalage vers le rouge (redshift)

Peu après la découverte des galaxies, à la moitié des années 20, les astronomes ont entrepris d'étudier les étoiles et les galaxies à partir de la lumière qu'elles émettent. Les observations actuelles utilisent soit des étoiles variables (des céphéides), soit des étoiles qui explosent : les supernovas. Plus précisément, les astronomes utilisent une classe bien précise de supernovas, qui ont pour particularité de générer systématiquement la même luminosité : les supernovas de type Ia. La luminosité perçue depuis la Terre de ces supernovas est proportionnelle à la distance.

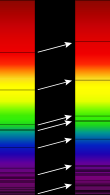

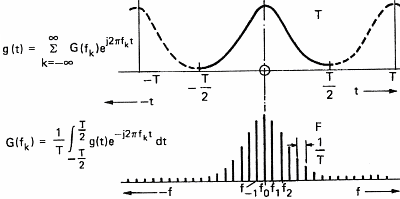

Les astronomes analysent la lumière émise par les étoiles et galaxies, afin d'en déduire énormément de chose. Ils ne se contentent pas d'analyser la luminosité ou la couleur des objets, ils étudient le spectre de la lumière émise. Par spectre, on veut dire l'ensemble des fréquences présente dans la lumière émise. Les galaxies et étoiles émettent de la lumière qui est une superposition d'onde électromagnétiques aux fréquences très diverses. L'ensemble forme ce qu'on appelle le spectre de la lumière et il ressemble à ceci :

Les trous dans le spectre, les bandes noires, s'expliquent par l'absorption de la lumière par les atomes. Les atomes absorbent la lumière dans des bandes de fréquence très précises, bandes qui sont des endroits très précis suivant l’élément chimique en question. La position des bandes permet de déterminer la composition chimique des étoiles/galaxies. L'étude des spectres de la lumière s'appelle la spectroscopie et astronomes l'utilisent beaucoup dans leurs observations astronomiques.

Le redshift des galaxies

modifierSi vous étudiez le spectre d'une galaxie, bous allez tomber sur la situation ci-contre. Les bandes semblent décalées par rapport à la fréquence habituelle. Les distances entre les bandes sont conservées, toutes les bandes semblent s'être décalées en bloc. Tout se passe comme si la lumière semble être décalée vers les basses fréquences (le rouge), comparée à sa couleur d'émission. Ce phénomène s'appelle le décalage vers le rouge ou encore le redshift.

Il est possible de quantifier le redshift par un paramètre mathématique noté . Pour quantifier ce phénomène, les physiciens utilisent le rapport entre le décalage des longueurs d'onde, et la longueur d'onde normale, attendue, celle mesurée sur Terre. Cette quantité, notée , est appelée le décalage vers le rouge, ou encore le redshift.

- , avec la longueur d'onde actuelle, mesurée lors d'une observation, et la longueur d'onde lors de l'émission du rayonnement.

Les observations sur les galaxies ont montré la présence de ce décalage vers le rouge, sans pour autant pouvoir l'expliquer. Un point intriguant est que le redshift varie fortement avec la distance. Plus une galaxie est éloignée, plus son spectre sera décalé vers le rouge.

La loi de Hubble

modifierHubble a été le premier astronome à mettre en équation ce comportement, dans son article daté de 1929. Il étudia un grand nombre d'observations provenant de ses collègues, ainsi que les observations qu'il avait effectuées lui-même. De ces observations, il induit une loi statistique, du nom de loi de Hubble. Dans sa formulation la plus fiable, elle dit que pour les galaxies proches, le redshift est proportionnel à la distance.

Suite à la découverte de Hubble, de nombreuses campagnes d'observations ont suivi et se sont poursuivies durant des décennies. Un exemple de résultats obtenus est le suivant. On voit que la relation de Hubble

La loi de Hubble ne fonctionne pas à longue distance

modifierInsistons sur le fait que la loi de Hubble ne fonctionne que pour des objets cosmologiques "proches". Par proche, on veut dire que leur décalage vers le rouge est proche de 1, guère plus. Pour de tels objets astronomiques, la concordance est franchement bonne. Mais pour les objets astronomiques plus lointains, la loi de Hubble ne fonctionne tout simplement pas et la relation entre distance et redshift devient tout autre. Elle cesse d'être linéaire, et devient alors beaucoup plus complexe.

Idéalement, il faudrait trouver une équation du redshift qui marche tout le temps. De telles formules empiriques existent, de même que d'autres formules basées sur la théorie de la relativité générale. Les scientifiques ont des logiciels dédiés pour faire les calculs et on peut trouver des calculateurs en ligne pour. Par exemple, vous pouvez utiliser ce site pour faire quelques calculs de distance en fonction du redshift :

L'interprétation de la relation redshift-distance

modifierMaintenant que nous connaissons la relation entre distance et redshift, encore faut-il l'expliquer. Et c'est là que le bât blesse ! Pour expliquer le décalage vers le rouge, il existe plusieurs solutions. Mais, comme nous allons le voir, les explications classiques sont rapidement mises en défaut.

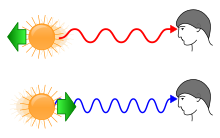

L'explication par l'effet Doppler

modifierPour expliquer le décalage vers le rouge des galaxies, Hubble pensa à l'effet Doppler-Fizeau, que les étudiants en physique connaissent bien. Quand un objet s'éloigne de nous à une certaine vitesse, la fréquence de la lumière qu'il émet baisse et la lumière parait rougie par rapport à la normale. Et réciproquement, un objet qui s'approche émettra une lumière plus bleuie, dont la fréquence a légèrement augmenté. Le redshift est alors causé par la vitesse de l'objet qui s'approche ou s'éloigne.

La loi de Hubble proprement dite

modifierIl existe une formule qui associe la vitesse de l'objet et le décalage vers le rouge, qui est différente selon que l'on travaille en physique newtonienne, en relativité restreinte ou en relativité générale. La physique classique donne la formule suivante, entre la vitesse de l'objet en mouvement et le décalage vers le rouge qui en découle.

On peut réécrire la formule précédente de manière à obtenir la vitesse de l'objet à partir de son redshift :

En utilisant cette formule et en combinant celle-ci à ses observations sur le redshift, Hubble formula une loi statistique, du nom de loi de Hubble, dit que la vitesse d'éloignement d'une galaxie est proportionnelle à sa distance. Le facteur de proportionnalité nommée paramètre de Hubble, il est noté H.

- , où v est la vitesse extrapolée du redshift, d la distance de la galaxie et H le facteur de Hubble.

La formule précédente est en réalité une extrapolation basée sur l'hypothèse que le redshift est bien causé par une vitesse. En réalité, ce qu'Hubble avait observé, c'est que le redshift était égal à :

La loi de Hubble est approximative, car les galaxies ne s'éloignent pas toutes à la même vitesse. Certaines vont plus vite, d'autres moins vite. Il faut faire la différence entre la vitesse donnée par la loi de Hubble, qui est une moyenne, et la différence avec la vitesse moyenne.

L'interprétation en termes de vitesse était tout simplement fausse et il n'a pas fallu longtemps pour s'en rendre compte. Appliquées de manière naïve à des galaxies lointaines, les redshift observés correspondent à des vitesses supérieures à celle de la lumière dans le vide. De telles vitesses supraluminiques sont un signe que la cause du décalage vers le rouge demande une explication relativiste. Une manière de sauver le tout serait d'utiliser des formules d'effet Doppler tirées de la relativité restreinte, plus adaptées aux forts redshifts, mais nous verrons plus bas que de telles explications ne marchent pas.

L'expansion de l'univers

modifier

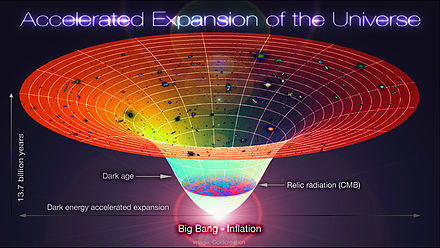

L'interprétation initiale, à base d'effet Doppler, indique que les galaxies s'éloignent toutes de nous, comme si nous étions au centre de l'univers, et que les galaxies tentaient de le fuir. La conclusion est claire : l'univers s'étend, gonfle. Les astronomes ont appelé ce phénomène l'expansion de l'univers. Pourtant, on aurait dû s'attendre à l'inverse : la gravité est censée rapprocher les galaxies les unes des autres.

A cause de l'expansion de l'univers, il est évident que l'univers devait être plus "petit" par le passé (plus précisément, la portion de l'univers qui correspond aujourd'hui à l'univers observable). En renversant l'écoulement du temps, l'univers se contracte progressivement, et on peut facilement imaginer qu'après un certain temps, tout le contenu de l'univers soit rassemblé en un seul point : la singularité initiale. L'univers serait alors né d'une dilatation de cette singularité initiale, dilatation qui porte le nom de big-bang.

Mais cette vue de l'esprit pose de nombreux problèmes mathématiques. En effet, cette singularité implique que de nombreux calculs dépendant des distances donnent des divisions par zéro. Par exemple, le calcul de la pression, de la température, de la densité, ou d'autres paramètres physiques ne sont pas calculables. Tout ce que peuvent faire les scientifiques, c'est étudier ce qu'il s'est passé quelques secondes ou minutes après le temps qui correspond à cette singularité hypothétique. Les calculs actuels ne donnent plus de résultats crédibles au-delà d'une certaine durée, la durée de Planck. Celle-ci vaut environ secondes.

L'expansion de l'univers est une manière d'expliquer les observations de Hubble, qui est compatible avec l'interprétation du redshift comme un effet Doppler. Cependant, le fait que les redshift donnent des vitesses supra-luminiques semblent indiquer qu'il faut expliquer tout cela avec une théorie relativiste. Voyons ce que la relativité peut dire là dessus.

L'explication par le décalage vers le rouge gravitationnel

modifierUne autre explication est le décalage vers le rouge gravitationnel, aussi appelé décalage d'Einstein. Il s'agit d'une conséquence de la relativité générale, observé expérimentalement. Sans rentrer dans les détails, il dit que la fréquence de la lumière change quand elle traverse un champ gravitationnel. Précisément, si on prend une masse M qui génère un champ de gravité, la lumière bleuit en se rapprochant de la masse, elle rougit en s'en éloignant.

Vous avez peut-être pensé que c'était le candidat idéal pour expliquer le redshift des galaxies, mais c'est en réalité le pire. La gravité de la terre ou de notre galaxie est une mauvaise explication : elle a tendance à faire bleuir la lumière qui s'approche de nous, sans compter que les calculs montrent que cela n'explique pas la relation redshift-distance.

En réalité, la lumière émise par les galaxies se rapproche de nous, elle rougit, ce qui signifie qu'elle s'éloigne de la source de gravité responsable du décalage vers le rouge. Et le redshift est observé pour toutes les galaxies, dans tous les sens, peu importe où on regarde sur la voute céleste. Cela signifie que la distribution des masses serait franchement bizarre, avec la terre au beau milieu d'un creux gravitationnel. Chose étrange, sachant qu'on est dans une galaxie et que la distribution des galaxies est assez homogène dans l'univers... Le décalage d'Einstein n'est pas la solution.

L'hypothèse de la lumière fatiguée

modifierLes deux idées précédentes font que l'univers n'est pas statique :, il est en expansion avec l'explication par l'effet Doppler, en contraction gravitationnelle avec le décalage d'Einstein. Mais l'intuition nous ferait plutôt penser à un univers statique, sans expansion ni contraction. Aussi, diverses théories ont tenté d'expliquer les redshifts galactiques sans recourir à un univers en expansion/contraction.

La théorie de la lumière fatiguée est une ancienne hypothèse visant à expliquer le redshift et sa variation en fonction de la distance avec un univers statique. L'idée est que sur de longues distances, la lumière interagit avec la matière, ce qui lui fait perdre de l'énergie, ce qui réduit sa fréquence et la décale vers le rouge. Plus la distance est grande, plus la lumière a interagit avec la matière et plus le décalage vers le rouge serait grand. L'idée a été formalisée dans de nombreuses théories différentes, qui se distinguaient par des détails. Mais l'idée de base est la même pour toutes ces théories.

Mais elle a de nombreux défaut, comme le fait que les images de galaxies lointaines devraient être plus floues qu'observé, du fait de la dispersion de la lumière lors des interactions lumière-matière. Cela ne veut pas dire que la lumière n'a pas interagit avec la matière lors de son trajet, mais cela ne suffit pas à expliquer la loi de Hubble.

De plus, d'autres observations vont contre ce mécanisme. Par exemple, la luminosité angulaire des galaxies devrait être constante dans un univers sans expansion avec lumière fatiguée, alors que les observations montrent qu'elle diminue avec la distance. La formalisation de cet argument a donné naissance au test empirique nommé le test de luminosité surfacique de Tolamn (Tolman surface brightness test). Et les résultats de ce test ont montré que les théories de la lumière fatiguée ne tiennent pas la route. D'autres observations plus complexes à expliquer vont à l'encontre des théories de la lumière fatiguée, comme des observations sur les courbes de luminosité des Supernovae, mais surtout : les observations du fond diffus cosmologique qu'on verra dans quelques chapitres.

L'explication du redshift cosmologique par la relativité générale

modifierAussi bizarre que cela puisse paraitre, les savants de l'époque n'étaient pas étonnés de voir apparaitre loi de Hubble, ni des galaxies aux vitesses supra-luminiques. La théorie de la relativité générale, qui existait déjà à l'époque, avait déjà permis de prédire que de telles situations pouvaient arriver. Et la relativité générale fournit un cadre explicatif parfait pour rendre compte des observations sur le redshift. De plus, la théorie de la relativité générale, appliquée à l'univers, explique parfaitement le paradoxe d'Olbers vu au chapitre précédent.

L'interprétation du redshift comme un effet Doppler son aujourd'hui abandonnée, au profit d'une explication totalement différente, basée sur la relativité générale. Dans cette interprétation, la relation est toujours valable, c'est l'équation pour le redshift qui est fausse. Et nous allons détailler cette explication dans le chapitre suivant.

L'expansion de l'univers

Les équations de la relativité expliquent le redshift cosmologique avec le concept d'expansion de l'univers : les corps matériels de l'univers s'éloignent les uns des autres au fil du temps. Les interprétations de la relativité disent que l'expansion de l'univers ne provient pas d'un mouvement des objets dans l'espace, mais d'une modification de la manière de calculer les distances avec le temps. L'image qui est souvent donnée dans la vulgarisation scientifique compare l'univers avec un gâteau au raisin qui gonfle progressivement, les raisins étant les galaxies.

Le facteur d'échelle, les distances, et le facteur d'échelle

modifierMettre en équation le phénomène d'expansion de l'univers est assez trivial. Du fait de l'expansion, toute distance entre deux points sera multipliée par un facteur multiplicatif après une durée t. Pour calculer ce facteur multiplicatif, les physiciens font intervenir ce qu'on appelle le facteur d'échelle, noté . Dans ce qui va suivre, nous allons supposer que nous prenons toutes les mesures dans un référentiel d'origine O, et que nous suivons la distance d'un objet matériel en fonction du temps. Nous allons comparer les distances entre un instant et un instant ultérieur. L'augmentation des distances à cause de l'expansion de l'univers se calcule comme suit :

Le rapport des facteurs d'échelle est un coefficient multiplicateur qui dit par combien les distances ont été multipliées entre l'époque actuelle et l'instant . Dit autrement, le facteur d'échelle est ce par quoi il faut diviser les distances actuelles pour obtenir les distances à l'instant .

- Notons que le facteur d'échelle est sans dimensions (il n'a pas d'unité).

Pour simplifier les calculs, on considère souvent que le facteur d'échelle vaut 1 à un instant idéal pour simplifier les calculs. Sous cette hypothèse, l'équation précédente se simplifie :

L’interprétation de cette équation est assez simple : si le facteur d'échelle augmente de X %, les distances font de même.

Les distances propres et comobiles

modifier

Reprenons la définition du facteur d'échelle vue précédemment :

Il est possible de réécrire la formule précédente comme suit :

Les distances et sont égale à une distance corrigée de l'influence des facteurs d'échelle. et . Elle peut s'interpréter comme la distance qu'auraient deux objets s'il n'y avait pas d'expansion. Elle est appelée la distance comobile. À contrario, la distance tient compte de l'expansion, qui augmente les distances entre deux objets. Les distances qui tiennent compte de l'expansion, opposées aux distances comobiles, sont appelées des distances propres. Par définition, les distances propres sont celles que l'on peut mesurer, qui ne sont pas corrigées de l'influence du facteur d'échelle.

Il existe une définition alternative de la distance comobile. C'est la distance mesurée à l'instant où .

L'augmentation des distances liée au facteur d'échelle n'est pas très intuitive. Dans le monde réel, une expansion a un centre, un point central d'où s'éloignent les autres. Mais avec l'expansion de l'univers, ce n'est pas du tout le cas. Peu importe où l'on soit dans l'univers, tous les autres objets semblent s'éloigner de nous. Un habitant de la Terre verra toutes les galaxies lointaines s'éloigner de la Terre, mais un habitant de la galaxie d'Andromède verra lui aussi l'ensemble des galaxies s'éloigner de lui et non de la Terre ! C'est cette particularité qui fait que l'on doit recourir à un facteur d'échelle pour expliquer l'expansion.

Le lien entre vitesse et facteur d'échelle

modifierLa distinction entre distance comobile et propre peut aussi se faire pour les vitesses, volumes, surfaces et autres. Par exemple, il est possible de calculer une vitesse propre en dérivant la distance propre. Pour cela, on pourrait partir de la définition de la distance propre et en calculer la dérivée.

- Par souci de lisibilité, nous noterons parfois la dérivée première d'une variable , à savoir , comme ceci : . Le remplacement ne sera pas systématique, la notation étant plus courante et donc plus claire. La notation sera utilisée quand la notation est trop lourde, par exemple pour simplifier les formules de ce style : en .

Mais les calculs seraient alors un petit peu longs, bien que pas difficiles. Pour éviter ce petit désagrément, nous allons ruser. À la place, nous allons calculer la dérivée de la distance comobile. La dérivée de la distance comobile est naturellement une vitesse, appelée la vitesse comobile. Elle correspond à la vitesse qu'aurait un objet s'il n'y avait pas d'expansion. Elle traduit le fait que les objets s'éloignent ou se rapprochent même sans expansion. Sachant que la distance comobile est définie par , on a :

On utilise la formule de la dérivée d'un quotient :

On simplifie par :

Les deux termes : et sont techniquement des vitesses. Mais elles sont écrites en coordonnées comobiles, dans le référentiel où . Ce sont donc des vitesses que l'on ne peut pas mesurer. Pour passer dans le référentiel général, on doit multiplier par le facteur d'échelle :

Le terme n'est autre que la vitesse propre, la vitesse totale de l'objet qui incorpore les effets de l'expansion.

Cette équation peut se reformuler comme suit :

Le terme est ce qu'on appelle la vitesse locale. C'est la vitesse qu'a l'objet quand on retire l'effet de l'expansion, mais qu'on prend quand même en compte le facteur d'échelle. En effet, la vitesse comobile est mesurée dans un référentiel particulier, où . Et ce référentiel est situé arbitrairement dans le temps, pas forcément dans le temps présent. Pour obtenir la vitesse indépendante de l'expansion, on doit multiplier la vitesse comobile par , afin de tenir compte de la multiplication des distances au cours du temps.

On voit que la vitesse propre est la somme de deux vitesses. Une vitesse indépendante du facteur d'échelle et une autre qui dépend du facteur d'échelle. En clair, une vitesse indépendante de l'expansion et une qui y est proportionnelle. La première est une vitesse locale indépendante de l'expansion, alors que le second terme a pour origine l'expansion. Nous allons l'appeler la vitesse d'expansion, bien que ce ne soit pas une vitesse.

En réalité, les seules vitesses sont des vitesses comobiles. Qui dit vitesse dit déplacement d'un objet dans l'espace, donc dans les coordonnées comobiles. L'extension de l'espace n'est pas une vitesse, elle correspond à une modification de l'espace lui-même, pas quelque chose qui se passe dedans, ce n'est pas le déplacement d'un objet matériel ou d'une onde. Si la vitesse locale ne peut dépasser la vitesse de la lumière, la vitesse de l'expansion n'est pas contrainte par car ce n'est pas une vitesse.

Le paramètre de Hubble

modifierTous les développements précédents permettent de retrouver la loi de Hubble. Pour les objets éloignés, la vitesse locale est négligeable par rapport à la vitesse d'expansion. Il est donc utile, de supposer la vitesse locale nulle. Sous cette hypothèse, l'équation précédente se simplifie comme suit :

La loi de Hubble ressemble trait pour trait à l'équation précédente, jugez plutôt :

En combinant les deux équations, on trouve :

La loi de Hubble est donc un pur dérivé de l'expansion de l'univers. La vitesse mesurée par la loi de Hubble est donc une pseudo-vitesse liée à l'expansion, pas une vitesse propre. Cela explique pourquoi certaines galaxies très lointaines semblent s'éloigner de nous plus vite que la lumière avec la loi de Hubble. En réalité, il ne s'agit pas d'une vitesse propre, limitée par la vitesse c. En réalité, il s'agit d'une pseudo-vitesse liée à l'expansion de l'espace, c'est la vitesse d'expansion. Ainsi, la vitesse supraluminique des galaxies lointaines provient de la vitesse de l'expansion et ne reflète pas une véritable vitesse supraluminique.

Au passage, cela explique pourquoi la loi de Hubble ne fonctionne pas pour les grandes distances. Les développements précédents permettent de calculer une vitesse instantanée, calculée avec des dérivées. Mais dans les faits, rien ne dit que le paramètre de Hubble H est constant dans le temps. Si celui-ci a varié, alors la loi de Hubble finit fatalement par être fausse. La variation de H a été assez lente dans le temps, ce qui fait que la loi de Hubble marche bien avec les galaxies proches, pour lesquelles la lumière a mis peu de temps à nous parvenir. Pour les galaxies lointaines, H a varié durant le temps de trajet de la lumière, ce qui fausse le lien entre distance et redshift.

Notons une grande différence entre la loi de Hubble , qui est une relation fondamentale, et la loi de Hubble liée au redshift. La relation entre vitesse et redshift dans un univers relativiste est assez complexe. Aussi, l'application de la loi de Hubble aux observations astronomique est assez complexe.

Le paramètre de Hubble est la rapidité instantanée de l'expansion de l'univers

modifierL'équation précédente peut se reformuler comme suit :

Comme on le voit, la démonstration précédente nous donne une nouvelle interprétation du facteur de Hubble : c'est la dérivée logarithmique du facteur d'échelle.

| Pour rappel, la dérivée logarithmique d'une fonction se note et est définie par :

Elle porte ce nom car elle est égale à la dérivée du logarithme de la fonction initiale : Cela nous permet de faire une remarque importante dans la suite du cours : l'intégrale d'une dérivée logarithmique est tout simplement le logarithme de la fonction. Nous ferons ce raccourci très souvent dans le cours. |

Pour le dire plus clairement, le facteur de Hubble est le taux, du pourcentage auquel l'expansion a lieu. Pour information, la dérivée s’interprète comme la vitesse de l'expansion de l'univers, la vitesse à laquelle croît le facteur d'échelle. Plus la vitesse de l'expansion est grande, plus l'univers grandit vite et s'étend rapidement. De même, la dérivée seconde de est l'accélération de l'expansion de l'univers : plus elle est grande, plus l'expansion devient de plus en plus rapide avec le temps. Le facteur de Hubble est donc la vitesse de l’expansion divisée par le facteur d'échelle, soit le taux de variation du facteur d'échelle. Intuitivement, il indique approximativement si le facteur d'échelle augmente de 5 %, 10 % ou 20 % par unité de temps. Si H vaut 0,015, cela signifie que les distances augmentent de 1,5 % par seconde.

- Faites attention à ne pas confondre la vitesse de l'expansion avec la vitesse d'expansion qui est la vitesse d'un objet acquiert à cause de l'expansion.

Maintenant, partons de l'équation précédente et intégrons-la :

On prend l'exponentielle et on réorganise l'équation :

Cette équation permet de calculer le facteur d'échelle quand on connait le facteur de Hubble. L'utilité de cette équation est qu'estimer le facteur de Hubble au cours du temps est possible, même si c'est par des moyens indirects. Les observations astronomiques permettent d'avoir une estimation précise de la valeur actuelle du facteur de Hubble, ainsi que de ses valeurs anciennes. Alors que l'évolution du facteur d'échelle ne l'est pas.

Le redshift cosmologique

modifierOn vient de démontrer la loi de Hubble , ce qui signifie qu'elle est valable en tout lieu, à tout instant. Mais n'en déduisez pas que les formules du redshift vues dans le chapitre précédents le sont. En réalité, la relation redshift-distance n'est pas celle obtenue en combinant la loi de Hubble avec la formule de l'effet Doppler, elle est un peu différente, même si elle ressemble. Dans cette section, nous allons montrer comment l'expansion de l'univers explique le décalage vers le rouge, sans recourir à un effet Doppler.

Le redshift cosmologique est causé par une modification du facteur d'échelle, valable quel que soit le référentiel. En effet, l'expansion de l'univers impacte aussi la longueur d'onde de la lumière, qui est une distance comme une autre. En clair, il influence la lumière lors de son trajet, mais n'a rien à voir avec la vitesse de l'objet émetteur.

Si une onde lumineuse est émise avec la longueur d'onde à un instant , sa longueur d'onde à un instant sera égale à :

La fréquence d'une onde lumineuse étant proportionnelle à sa longueur d'onde, on a alors :

La relation entre redshift et facteur d'échelle

modifierIl est possible de démontrer une relation entre le facteur d'échelle et le redshift. Pour cela, partons de la définition du redshift z :

On utilise alors l'équation , réécrite comme ceci :

En combinant les deux équations précédentes, on déduit la valeur du décalage vers le rouge en fonction du facteur d'échelle. Dans ce qui suit, on suppose que est l'instant d'émission de la lumière, alors que l'observation a lieu à l'instant .

Posons que le facteur d'échelle actuel vaut 1. L'équation obtenue est alors la suivante :

La relation entre redshift et paramètre de Hubble

modifierQuelques manipulations algébriques à partir des équations précédentes permettent d'exprimer le facteur de Hubble en fonction du redshift. Pour cela, partons de l'équation suivante :

Prenons la dérivée par rapport au temps :

Le calcul de la dérivée donne :

On applique la formule :

On multiplie les deux côtés par

Maintenant, utilisons l'équation :

La relation entre redshift et temps écoulé depuis l'émission d'un photon

modifierL'équation précédente permet de calculer quel temps temps s'est écoulé depuis qu'un photon a été émis, en fonction de son redshift. Pour cela, prenons l'équation précédente et isolons dt, en multipliant par . On obtient alors le temps dt qu'il faut pour obtnir un incrément de redshift dz.

Intégrons cette formule entre O et z :

Il est possible de mettre l'équation précédente sous la forme suivante :

- , avec

- Le signe moins disparait car z est négatif, vu que t=0 correspond à maintenant et que z est localisé dans le passé.

Évidemment, résoudre cette équation demande de connaitre E(z), ce qui demande d'avoir un modèle cosmologique sous la main. En utilisant le modèle actuel, on trouve la relation suivante :

La relation entre redshift et distance d'une source

modifierLa distance parcourue par la lumière lors de son trajet n'est autre que le temps précédent multiplié par la vitesse c. La distance en question s'appelle la light-travel distance.

- , avec

Remarquez que le terme n'est autre que la distance telle que calculée par la loi de Hubble. Si on note celle-ci , on a :

- , avec

Mais il s'agit là d'une distance un peu trompeuse. Il s'agit de la distance parcourue par le photon, mais pas de la distance actuelle à laquelle se situe la source qui a émis la lumière. En effet, l'expansion agit tout le temps et fait que la source s'est éloignée pendant que le photon faisait son voyage.

Il est cependant possible de calculer la distance comobile parcourue par le photon, ce qui demande de diviser le contenu de l'intégrale par le facteur d'échelle a(t), ce qui donne :

- , avec

Or, , ce qui fait que l'équation précédente se simplifie en :

On peut obtenir la distance actuelle entre source et récepteur de la lumière en multipliant l'équation précédente par le facteur d'échelle.

Pour exploiter cette équation, toute la difficulté consiste à connaitre E(z), et donc de savoir comment le facteur de Hubble a évolué dans le temps.

Le redshift des galaxies proches et la loi de Hubble

modifierNous allons maintenant supposer que le facteur de Hubble H est resté constant. Dans ce cas, les équations précédentes se simplifient un peu. Les équations pour le temps de parcours et la distance sont donc égales à :

En faisant l'intégrale, on trouve :

En reformulant retrouve la loi de Hubble :

En clair, la loi de Hubble ne fonctionne que dans les cas où le paramètre de Hubble n'a pas trop varié entre l’émission du photon et sa réception. En clair, elle marche pour des petites distances et/ou des durées assez courtes, ce qui correspond aux galaxies proches. Mais pour les observations de galaxies très éloignées, cette formule ne tient juste plus la route. Plus E(z) s'éloigne de 1, plus la relation précédente donne des résultats erronés. L'observation de galaxies à fort redshift et le calcul de leur distance doit se faire avec l'aide d'un modèle cosmologique qui dit comment E(z) a évolué dans le temps, sous peine d'obtenir des résultats invalides.

L'accélération de l'expansion de l'univers

modifierIl est intéressant de savoir si l'expansion se fait à vitesse constante, ou si l'expansion accélère/décélère. Pour simplifier les calculs, nous allons omettre la vitesse de la lumière et nous concentrer sur la vitesse de l'expansion de l'univers. Cela ne change rien aux résultats que nous allons obtenir vu que la vitesse de la lumière est constante : sa dérivée est donc nulle, ce qui la rend inutile dans les calculs de dérivée qui vont suivre.

L'accélération de l'expansion en fonction du paramètre de Hubble

modifierUne première étape pour savoir si l'expansion ralentit ou accélère, est de calculer l'accélération de l'expansion de l'univers. Cette accélération est simplement égale à la dérivée de la vitesse de l'expansion.

En développant, on a :

Or, est simplement la vitesse d'expansion calculée avec la loi de Hubble, ce qui donne :

Le tout se simplifie en :

L'accélération de l'expansion en fonction du facteur d'échelle

modifierUne autre manière de quantifier l'accélération de l'expansion est de calculer la dérivée du facteur de Hubble. Le raisonnement derrière cette définition est assez simple. Le facteur de Hubble dit à quel taux les distances dans l'univers augmentent avec le temps. Si la dérivée est nulle, le facteur de Hubble est constant : l'expansion n’accélère pas plus qu'elle ne décélère. Inversement, une dérivée non-nulle nous dit comment le facteur de Hubble varie, et donc comment évolue l'expansion. Si la dérivée est positive, l’expansion accélère, et elle décélère pour le cas négatif.

Sachant que , la dérivée du facteur de Hubble est la suivante :

On utilise alors la formule

Ce qui se simplifie, en utilisant le facteur de Hubble :

On peut réorganiser les termes pour obtenir l'équation suivante :

On peut en profiter pour identifier cette équation avec l'équation , ce qui donne :

Le facteur de décélération

modifierIl est courant que les cosmologistes utilisent ce qu'on appelle le facteur de décélération, un nombre calculé à partir du facteur de Hubble. Celui-ci est positif si l'expansion est décélérée, négatif si elle accélère, et reste constant si la vitesse d'expansion reste constante. Par définition, ce facteur de décélération q vaut :

En utilisant la formule , la formule précédente se reformule comme suit :

On utilise alors la formule :

Quelques manipulations algébriques donnent alors :

Les formules précédentes peuvent se réécrire sous la forme ci-dessous. Cette formule sera importante dans la suite du cours, car les deux termes et peuvent se calculer assez facilement. Dans les chapitres sur les équations de Friedmann, nous verrons que le premier terme se calcule à partir de la première équation de Friedmann et le second terme à partir de la seconde équation de Friedmann. Autant dire que l'étude des modèles cosmologiques est fortement facilitée quand on connaît cette relation.

Une autre formulation est la suivante :

La formule se démontre facilement si on calcule la dérivée suivante :

En combinant avec les équations précédentes qui donnent le facteur de décélération en fonction de , on retrouve l'équation précédente.

Le lien entre expansion et facteur de Hubble

modifierL'expansion, de part son action sur les distances, entraîne naturellement une variation des surfaces, volumes et densités. Prenons par exemple une sphère de rayon et de volume : son rayon augmentant avec le facteur d'échelle, son volume fera de même. Quelques calculs triviaux nous disent que son volume évolue avec le facteur d'échelle selon la formule suivante, avec le volume de la sphère à l'instant .

Cette équation nous permet de déduire le rapport entre le facteur de Hubble et l'expansion des volumes. Pour cela, commençons par calculer la dérivée du volume :

Divisons ensuite par V, ce qui revient à diviser par : :

On simplifie par et par :

La formule précédente peut aussi s'écrire de manière moins compacte comme ceci : .

Cette équation sera réutilisée plus tard dans le cours, quand nous démontrerons l'équation du fluide de Friedmann.

Le facteur de Hubble

Le facteur de Hubble est d'abord né des observations de Hubble, et précisément de la loi de Hubble, dit que la vitesse d'éloignement d'une galaxie est proportionnelle à sa distance.

- , où v est la vitesse extrapolée du redshift, D la distance de la galaxie et H un facteur de proportionnalité nommée paramètre de Hubble.

Nous avons vu qu'en réalité, cette relation est approximative et ne marche pas sur les galaxies lointaines. La véritable définition est plus profonde : le facteur de Hubble est un taux d'accroissement du facteur d'échelle, définit par :

Vous avez peut-être déjà entendu parler de la constante de Hubble pour désigner le paramètre de Hubble. C'était le terme utilisé au tout début de la cosmologie moderne, on pensait que H était constant, mais on sait aujourd'hui que ce n'est pas le cas. Ce n'est donc pas une constante, d'où le fait que nous parlerons de paramètre de Hubble dans de cours. La valeur actuelle de H est sous notée , et nous utiliserons cette notation dans ce cours.

La mesure du facteur de Hubble

modifierFormellement, le paramètre de Hubble est égal à une vitesse divisée par une distance, ce qui fait qu'elle est l'inverse d'un temps. Le paramètre de Hubble H a donc pour unité , soit l'inverse d'une seconde. Mais dans les faits, les astronomes l'expriment en kilomètres par seconde par mégaparsecs (km/s/Mpc ou . Pour rappel, le mégaparsec est une unité astronomique qui vaut environ 3,26 millions d'années-lumière. Avec de telles unités, le paramètre de Hubble actuel, mesuré aujourd'hui, vaudrait approximativement :

L'interprétation de cette valeur est que chaque seconde, l'univers grandit de 70 kilomètres par mégaparsecs.

Les mesures du paramètre de Hubble sont assez nombreuses, mais elles semblent converger vers la valeur de 70 mentionnée plus haut, avec cependant des incertitudes de mesure non-négligeables. Pour vous donner quelques exemples, les graphiques ci-dessous et ci-contre vous donnent les valeurs mesurées pour plusieurs compagnes d'observation assez anciennes. Vous voyez que la valeur n'est pas connue avec certitude.

À l'heure actuelle, les cosmologistes ne savent pas expliquer pourquoi les mesures du paramètre de Hubble sont aussi différentes. Ce qui est sûr, c'est que le résultat dépend fortement de la méthode de mesure. Sans rentrer dans les détails techniques, il existe plusieurs méthodes indirectes pour estimer le paramètre de Hubble, qui estiment les distances des objets lointains en analysant la luminosité des supernovæ, des galaxies, des céphéides (des étoiles pulsatiles), et d'autres objets astronomiques. Et suivant la méthode utilisée ou l'objet observé, le paramètre de Hubble n'a pas la même valeur. Peut-être que les mesures sont entachées d'un biais systématique qui dépend de la mesure, peut-être que la valeur du paramètre de Hubble varie suivant la distance des objets considérés, peut-être que l'hypothèse d'un univers isotrope et homogène doit être abandonné, peut-être qu'une nouvelle physique se cache derrière ces résultats disparates, personne ne le sait.

Les valeurs précédentes sont obtenues avec des objets situés à des distances très différentes, pour lesquels la lumière a mis du temps à nous parvenir. Aussi, vous avez peut-être pensé que les différences dans les mesures sont liés aux variations du paramètre de Hubble. Manque de chance, les scientifiques ne sont pas stupides et ils ont pris cela en compte. Les valeurs des graphiques précédents sont des valeurs qui corrigent l'évolution du paramètre de Hubble, à partir d'hypothèses très crédibles sur son évolution.

Le temps de Hubble

modifierComme dit plus haut, le paramètre de Hubble est l'inverse d'un temps. Ce temps en question est appelé le temps de Hubble et nous le noterons . Par définition, il vaut :

Il vaut environ 14,4 milliards d'années et cette valeur est très proche de celle actuellement admise par les scientifiques pour l'âge de l'univers (13,6 milliards d'années environ). Précisons que si les estimations actuelles nous disent que les deux sont assez proches, mais rien ne nous dit qu'ils sont exactement identiques. Les mesures et estimations sont en effet entachées d'une marge d'erreur assez large, ce qui fait que les deux mesures peuvent sembler se confondre alors qu'elles sont peut-être légèrement différentes.

Le temps de Hubble n'est pas l'âge de l'univers, attention à ne pas confondre ! Un bon moyen de s'en rendre compte est de regarder ce qui se passe dans un univers où serait constant, mais positif et non-nul. Le temps de Hubble serait alors constant, alors que l'univers serait en expansion.

La théorie nous dit que temps de Hubble et âge de l'univers n'ont pas de raison de coïncider. Dans la plupart des théories mathématiques de la cosmologie, et âge de l'univers ne coïncident qu'en un seul instant bien précis. À tous les autres instants, ces deux valeurs sont différentes. Dans de nombreuses théories cosmologiques, le temps de Hubble est plusieurs fois inférieur ou supérieur à l'âge de l'univers.

La seule exception est un modèle théorique appelé le modèle (oui, le nom de cette théorie est bien une formule mathématique...), dans lequel le temps de Hubble et l'âge de l'univers se confondent à tout instant. Mais c'est l'exception qui confirme la règle. À l'heure actuelle, on ne sait pas si ce modèle décrit correctement l'univers actuel. Aussi, les scientifiques ne savent pas si la coïncidence actuelle entre temps de Hubble et âge de l'univers en est une ou est valide en permanence.

Le lien entre temps de Hubble et facteur de décélération

modifierLe temps de Hubble a un lien assez important avec le facteur de décélération. Pour nous en rendre compte, prenons la formule suivante pour le facteur de décélération :

L'interprétation de cette équation est assez simple, si on regarde comment évolue la dérivée . Le cas où correspond au cas où le temps de Hubble augmente au même rythme que l'âge de l'univers, ce qui signifie que les deux sont égaux. Or, nous verrons dans quelques chapitres que ce n'est possible que si l'expansion de l'univers se fait à vitesse constante. Plus précisément, cela implique que le facteur d'échelle augmente linéairement avec le temps (), donc que sa dérivée première soit constante et sa dérivée seconde nulle.

Les cas où et correspondent alors à une expansion supra- et infra-linéaire. Or, le facteur de décélération est définit de manière à valoir 0 pour un univers en expansion linéaire (à vitesse constante), positif pour une expansion supra-linéaire et négatif pour une expansion infra-linéaire. On voit que pour passer de la dérivée au facteur de décélération, il faut retrancher 1.

Une autre manière de réécrire cette formule, qui sera utile dans la suite du cours, est la suivante :

Le facteur de décélération moyen

modifierRien n'implique que le facteur de décélération soit une constante. Il peut très bien varier dans le temps, si le facteur de Hubble varie lui aussi. Rien n’empêche d'avoir un univers dont l'expansion accélère, puis stoppe et décéléré, par exemple. Il est alors utile de calculer un facteur de décélération moyen, qui est définit par :

- , avec l'âge de l'univers.

On utilise alors l'équation :

L'intégrale d'une somme est la somme des intégrales :

On calcule la dernière intégrale :

On développe :

L'intégrale et la dérivée s'annulent si on néglige les constantes d'intégration, ce qui donne :

On voit que le facteur de décélération moyen dépend de l'âge de l'univers et du facteur de Hubble actuel, rien de plus. C'est un résultat très intéressant, qui permet soit de calculer le facteur de décélération moyen à partir de l'âge de l’univers, ou de faire l'inverse. L'âge de l'univers vaut donc :

Plus haut, nous avons dit que l'âge de l'univers qui fait actuellement consensus est proche du temps de Hubble. Si on en croit l'équation précédente le seul moyen d'avoir est que . En clair, l'univers a eu une expansion approximativement constante, en moyenne. Mais attention, cela ne signifie pas que l'expansion s'est faite de manière régulière tout le temps. Le consensus actuel est que l'univers a alterné entre décélération et d'expansion. Mais nous reparlerons de cela plus tard dans le cours, quand nous parlerons des modèles cosmologiques, de l'accélération de l'expansion de l'univers et de l'inflation.Toute la difficulté de la cosmologie est d'établir comment s'est déroulée l'expansion.

Le rayon de Hubble

modifierLe rayon de Hubble, noté , est la distance que parcourt la lumière pendant le temps de Hubble. Il vaut donc, par définition :

Notons que cette dernière formule est une tautologie sans grande importance, sans sens physique. Dans la plupart des modèles cosmologiques, temps de Hubble et rayon associé n'ont pas de sens physique et ne sont que des conventions. Par exemple, si on suppose que le facteur de Hubble est constant, le rayon de Hubble est constant, alors que l'univers est en expansion.

Un autre point important est que le rayon de Hubble n'est en rien la limite au-delà de laquelle la lumière n'a pas eu le temps de nous parvenir (en termes scientifiques, ce n'est pas un horizon). On peut parfaitement voir des objets qui sont situés au-delà du rayon de Hubble, et les astronomes l'ont déjà fait. Bref, temps et rayon de Hubble sont des conventions.

La relation entre redshift et rayon de Hubble

modifierOn a vu que pour les faibles redshift, la loi de Hubble donne une relation entre distance et redshift qui s'écrit comme suit :

Le terme n'est autre que l'inverse du rayon de Hubble, ce qui donne :

Rappelons que cette relation ne vaut que pour des distances assez faibles, des galaxies proches.

L'évolution du rayon de Hubble

modifierOn peut s'amuser à calculer dans quelles circonstances le rayon de Hubble est constant. Pour cela, prenons sa dérivée :

On utilise alors la formule qui relie la dérivée du temps de Hubble au facteur de décélération :

En combinant les deux équations précédentes, on trouve :

Cette dérivée s'annule quand . En analysant la dérivée, on remarque que le rayon de Hubble se contracte pour , augmente quand , et reste stationnaire pour . En clair, le rayon de Hubble augmente quand l'expansion qui ralentit, diminue quand l'expansion accélère, reste constante si l'expansion se fait à taux constante.

Le rayon de Hubble et les vitesses de fuite supra-luminiques

modifierAu-delà du rayon de Hubble, le produit dépasse la vitesse de la lumière. En effet, calculons la distance à laquelle la vitesse calculée avec la loi de Hubble vaut c :

On a alors :

Prenons n'importe quel objet qui émet de la lumière vers nous. La lumière va a une vitesse c vers nous, mais l'expansion fait que la lumière s'éloigne de nous à une vitesse qui se calcule avec la loi de Hubble. La vitesse des photons venant vers nous, en coordonnées non-comobiles, est donc de .

Pour les objets au-delà du rayon de Hubble, : ils s'éloignent de nous plus vite que la lumière. Ce qui fait que leur lumière ne devrait pas nous rejoindre si le rayon de Hubble restait statique, car elle est supérieure à c. Mais il faut maintenant prendre en compte que le rayon de Hubble grandit à la vitesse qu'on vient de calculer plus haut. Ce qui fait que ces photons dont se retrouvent quand même dans la sphère de Hubble, s'ils respectent la condition suivante :

Utilisons la formule suivante :

Combinons les deux équations précédentes :

Simplifions :

En clair, le rayon de Hubble finit par rattraper ces photons, ce qui fait qu'ils finissent par arriver chez nous.

Le rayon comobile de Hubble

modifierNotons que l'on peut calculer le rayon de Hubble comobile, c'est à dire en supprimant l'effet de l'expansion. Ce rayon n'a pas plus de sens physique que le rayon de Hubble normal. Il est définit comme toute distance comobile, en divisant par le facteur d'échelle. Cela donne :

En utilisant la formule et en simplifiant, on trouve :

Le rayon comobile est constant si la dérivée du facteur d'échelle est constante, ce qui correspond à une expansion linéaire, où le facteur d'échelle augmente proportionnellement avec le temps.

L'univers observable

L'univers observable est la portion de l'univers que nous pouvons observer, compte tenu de la limite de la vitesse de la lumière. Des objets situés très loin ne peuvent pas être vus pour une raison très simple : la lumière qu'ils émettent n'a pas eu le temps de nous parvenir. La distance maximale à laquelle nous pouvons voir des objets (sans tenir compte d'éventuelles limitations techniques) dépend de l'âge de l'univers. S'il faut un temps supérieur à l'âge de l'univers pour nous parvenir, il nous est actuellement impossible de les voir, ce qui n'est pas le cas pour des objets situés plus près. Cette distance maximale est donc le rayon de l'univers observable. L'ensemble des points situés à la distance maximale des objets observables, à savoir la surface de l'univers observable, porte un nom : c'est l'horizon cosmologique.

Le rayon de Hubble

modifierOn pourrait croire que le rayon de Hubble est une bonne estimation de la taille de l'univers observable. Pour rappel, ce rayon de Hubble est définit à partir du facteur de Hubble comme suit :

- , avec c la vitesse de la lumière et le temps de Hubble définit par .

Il s'agit de la distance parcourue par la lumière pendant le temps de Hubble, lui-même définit comme l'inverse du facteur de Hubble. Mais le rayon de Hubble n'est malheureusement pas une bonne estimation du rayon de l'univers observable, pas plus que le temps de Hubble ne donne l'âge de l'univers. En effet, le rayon de Hubble n'est en rien la limite de l'univers observable : on voit des objets sont situés au-delà et on peut calculer leur redshift ou tout autre mesure pertinente.

Pourtant, sa définition semble indiquer que le rayon de Hubble soit la limite de l'univers observable. Par définition, tout ce qui est au-delà du rayon de Hubble va plus vite que la lumière. Donc la lumière émise au-delà de ce rayon n'est pas censée nous atteindre. Sauf que ce raisonnement par du principe que le rayon de Hubble est stable. Or, rappelez-vous l'équation du chapitre précédent, qui dit comment évolue le rayon de Hubble :

Pour notre univers, tout semble indiquer qu'il augmente avec le temps. Et cela explique pourquoi on peut voir des objets qui se déplacent "plus vite que la lumière", dans le sens où l'expansion les éloignait de nous plus vite que la lumière. La raison est que, vu que le rayon de Hubble grandit, certains photons hors du rayon de Hubble finissent par y rentrer. Ils sont en quelque sorte rattrapés par le rayon de Hubble et nous finiront donc par les voir une fois arrivés sur Terre. Par contre, les objets qui ont émis cette lumière s'éloignent bien de nous plus vite que la lumière et restent au-delà du rayon de Hubble.

Le rayon de l'univers observable

modifierLe calcul du rayon cosmologique actuel est assez simple sur le principe, mais compliqué en pratique. Une méthode assez simple se base sur la vitesse d'éloignement de l'horizon, à savoir la vitesse à laquelle l'horizon cosmologique s'éloigne de nous. Une fois cette vitesse connue, il suffit de l'intégrer sur l'âge de l'univers.

La vitesse d'éloignement du rayon observable est définie par :

- , avec le rayon de l'univers à l'instant t.

On réutilise l'équation du chapitre précédent, qui donne la vitesse en fonction de la distance: . Dans le cas de l'horizon cosmologique, la distance est égale au rayon de l'univers et la vitesse locale est égale à la vitesse de la lumière, ce qui donne :

On peut reformuler le tout en divisant par , ce qui donne :

On peut alors intégrer cette expression sur l'âge de l'univers pour obtenir le rayon de l'horizon cosmologique, du moins dans certaines conditions. Faire les calculs demande de connaître la loi d'évolution du facteur de Hubble . Mais dans les faits, elle nous est inconnue et on n'en a que quelques bribes. La théorie ne nous est pas d'un grand secours et le seul cas que l'on peut calculer simplement est celui où le facteur de Hubble est constant. En général, les modèles cosmologiques les plus simples supposent que le facteur d'échelle suit une loi de puissance, de type , ce qui fait que l'équation peut se résoudre avec quelques développements analytiques. Mais des modèles plus réalistes ne suivent pas vraiment une loi de puissance, ce qui complique les calculs. Pour nous éviter de longs calculs fastidieux, nous allons étudier le cas général, en utilisant quelques raisonnements astucieux.

Le rayon comobile de l'univers observable

modifierUne autre façon de faire les calculs est de passer par l'intermédiaire du rayon comobile. Pour rappel, ce rayon comobile est le rayon corrigé de l'influence du facteur d'échelle (et donc de l'expansion). Il vaut, par définition : .

La vitesse comobile est la dérivée de ce rayon comobile, qui est égale à :

On peut alors factoriser le rayon comobile :

On simplifie :

En injectant l'équation dans la précédente, on a :

En développant, on trouve :

On voit que la dérivée est égale à ce qu'on appelle la vitesse comobile de la lumière. Par définition, la vitesse de la lumière est de , mais il s'agit d'une vitesse propre. On peut calculer sa vitesse comobile en divisant par le facteur d'échelle, ce qui n'est autre que le premier terme de l'équation précédente. . En intégrant l'équation précédente sur l'âge de l'univers, on a la distance comobile de l'horizon, celle à laquelle se situait l'horizon cosmologique quand la lumière de l'horizon a été émise. On se retrouve alors avec une équation très générale, qui marche même quand le facteur de Hubble est variable.

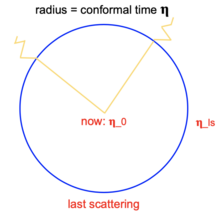

Seule la vitesse comobile de la lumière devant être prise en compte. On trouve alors que le rayon comobile se calcule avec la formule suivante, avec l'âge de l'univers :

Il est possible de simplifier fortement la formule précédente en faisant intervenir une variable particulière, appelée le temps conforme, définie par . On peut voir ce temps conforme comme l'équivalent de la distance comobile, mais pour les durées. Il n'a pas vraiment d'interprétation physique digne de ce nom et sert plus d'intermédiaire pour les calculs. Avec le temps conforme, la formule précédente devient alors :

- On peut voir la formule précédente comme la généralisation de la formule , mais où le temps est remplacé par le temps conforme.

Le rayon actuel de l'univers observable

modifierOn peut obtenir la distance propre par un calcul très simple, à partir de la distance comobile. Le passage de la distance comobile à la distance propre se fait simplement en multipliant par . On obtient alors la distance propre suivante :

Dans l'équation précédente, on peut factoriser la vitesse de la lumière, ce qui donne :

- Comme pour le rayon comobile, on peut voir la formule précédente comme la généralisation de la formule , mais où la durée est remplacée par la valeur temporelle .

Les intégrales précédentes ne sont pas solubles telles quelles. Il faut préciser comment le facteur d'échelle évolue avec le temps, sans quoi les intégrales ne peuvent pas être calculées exactement. Manque de chance, la loi d'évolution du facteur d'échelle nous est inconnue. Nous sommes obligés de postuler des fonctions particulières, en espérant qu'elles collent au mieux aux observations. Nous ferons cela plus en détail dans le chapitre sur les modèles cosmologiques.

Une introduction aux modèles cosmologiques

Les chapitres précédents nous ont appris beaucoup de choses. Ils ont fourni une description de l'expansion de l'univers basée sur le facteur d'échelle, de quoi calculer le rayon de l'univers observable, et ont décrit comment la matière et le rayonnement réagissent à l'expansion. Maintenant, nous allons voir une portion bien plus intéressante de la cosmologie. Nous allons étudier les modèles cosmologiques, des modèles théoriques qui décrivent comment l'univers lui-même a évolué au cours du temps. Les modèles cosmologiques que nous allons voir dans ce cours donnent au minimum les résultats suivants : l'évolution du facteur d'échelle au cours du temps (la fonction , le rayon observable de l'univers, son âge (s'il en a un), une formule pour le facteur de Hubble, et parfois d'autres données supplémentaires (T(t) : température à tout instant, ...).

Dans ce chapitre, nous allons voir quelques modèles cosmologiques ad hoc. Par ad hoc, on veut dire qu'on fait des hypothèses purement arbitraires pour démontrer le modèle. De tels modèles sont à contraster avec des modèles démontrés à partir de principes physiques fondamentaux. Les modèles démontrés à partir de lois physiques plus fondamentales sont en effet un peu plus compliqués et seront vus dans les chapitres qui suivent. Le prochain chapitre porte d'ailleurs sur les modèles de Friedmann, qui sont les modèles les plus utilisés en cosmologie physique. Dans ce chapitre, nous allons voir des modèles plus simples. La démarche de ce chapitre consistera simplement à postuler une loi d'évolution pour le facteur d'échelle, à postuler la fonction . Une fois cela fait, nous pourrons établir une formule pour le facteur de Hubble, le rayon cosmologique, etc. Une telle démarche demande de choisir une fonction en fonction de ses propriétés mathématiques, de sa facilité pour faire les calculs, etc. Dans les modèles cosmologiques physiques, cette loi est démontrée à partir de principes physiques plus fondamentaux.

Dans ce chapitre, nous allons voir plusieurs modèles. Le premier est celui pour lequel la loi est linéaire. Il s'agit d'un modèle très simple, mais qui n'est pas réaliste du tout. Cependant, ce modèle permet d'introduire deux grandeurs fondamentales : le temps et le rayon de Hubble. De plus, il sert de point de comparaison avec le second type de modèles : ceux pour lesquels la loi est une loi de puissance. Enfin, nous verrons ce qui se passe quand le facteur d'échelle croit de façon exponentielle. En soit, ces trois modèles font que l'univers est en expansion, mais de manière différente. Une croissance linéaire n'a rien à voir avec une croissance exponentielle, ni avec une croissance en loi de puissance. Nous verrons cependant que les modèles cosmologiques physiques, ceux de Friedmann, donnent une croissance soit exponentielle, soit en loi de puissance. Nous pourrons donc réutiliser les résultats de ce chapitre dans les chapitres ultérieurs sur les modèles physiques. Les modèles ad hoc que nous allons voir vont nous donner des résultats qui faciliteront l'étude de modèles plus physiques, plus compliqués.

Le modèle à croissance linéaire

modifierPour commencer, nous allons étudier un premier modèle : le modèle à croissance linéaire. Il est aussi appelé modèle , en raison d'une des équations du modèle[1]. Les cosmologistes ont étudié ce modèle à partir de l'année 2012, car de nombreux problèmes des autres modèles disparaissent dans ce modèle, mais il semble qu'il ne colle pas trop aux observations actuelles[2]. Quoi qu’il en soit, ce modèle est intéressant à étudier et il sert de bonne introduction, avant de passer à des modèles plus compliqués.

Avec ce modèle, on suppose que l'univers gonfle de manière relativement constante avec le temps. Mathématiquement, cela se traduit par la loi d'évolution suivante pour le facteur d'échelle :

- , avec le temps, une constante quelconque.

Une autre formulation, souvent utilisée, est la suivante :

- , avec l'origine de temps choisie arbitrairement et le facteur d'échelle à ce même instant.

Notons que les deux sont équivalentes, sous réserve que . Dans ce qui va suivre, nous utiliserons la première formulation, sauf pour ce qui est l'étude du décalage vers le rouge. Avec ces formules, nous allons calculer quelle est la valeur du facteur de Hubble qui correspond, quel est l'âge de l'univers, quel est son rayon, la vitesse de l'expansion de l'univers, etc.

Avant de poursuivre, on peut calculer la dérivée première et seconde du facteur d'échelle, deux résultats qui seront utiles pour la suite. Le calcul de la dérivée première donne :

Celle-ci étant une constante, la dérivée seconde est donc nulle.

Rappelons que la dérivée seconde du facteur d'échelle nous dit si l'expansion de l'univers accélère, ralentit ou reste constante. Pour une valeur nulle, l'expansion se fait à rythme constant.

Le calcul du facteur de Hubble et de l'âge de l'univers

modifierPour calculer le facteur de Hubble, nous allons partir de la dérivée du facteur d'échelle, qui est égale à :

En divisant par a(t), le terme de gauche devient le facteur de Hubble. On a alors :

On peut comparer l'équation précédente avec l'identité vue dans le second chapitre. On obtient alors :

L'âge de l'univers est égal au temps de Hubble dans ce modèle.

L'évolution du facteur de Hubble dans le temps

modifierDe l'équation , on peut déduire comment le facteur de Hubble H évolue au cours du temps. Pour cela, il suffit d'étudier ce qui se passe quand l'âge de l'univers augmente. Au fur et à mesure que le temps passe, l'âge de l'univers augmente. Ce faisant, le dénominateur de croit et le facteur de Hubble diminue donc. Pour le dire en termes mathématiques, le facteur de Hubble est une fonction décroissante du temps. Un bon moyen de s'en rendre compte est de calculer la dérivée du facteur de Hubble :

La dérivée étant négative, on en déduit que le facteur de Hubble décroit au cours du temps. Et cette décroissance est d'autant plus rapide que l'univers est âgé.

Le calcul du paramètre de décélération

modifierÀ partir des résultats précédents, on peut calculer la valeur du paramètre de décélération. Pour rappel, celui-ci est un nombre qui dit à quelle vitesse l'expansion de l'univers accélère ou ralentit. L'expansion est décélérée s'il est positif, accélère s'il est négatif et reste constante sinon. Il se calcule en utilisant la formule suivante, vue dans le chapitre sur l'univers observable :

On injecte alors les équations et , ce qui donne :

En clair, l'expansion garde un rythme constant, elle n’accélère pas et ne ralentit pas, comme dit précédemment.

Le rayon de Hubble

modifierPar définition, le rayon de Hubble est égal à :

En combinant avec l'équation , on a :

- Le modèle à expansion linéaire est aussi appelé modèle , en raison de ce résultat. D'ailleurs, c'est le seul modèle dans lequel cette égalité est tout le temps vraie. Si l'on a pas une expansion linéaire, alors le rayon de Hubble n'est égal à que pour une valeur de bien précise et fausse pour toutes les autres.

Le rayon comobile de Hubble est définit par la formule :

Par définition, on a , qui est une constante.

On remarque que toute la partie de droite ne contient que des termes constants (c et k sont tous deux constants). Ce qui signifie que le rayon comobile de l'univers est lui aussi constant. Certes, le rayon de Hubble grandit, mais il le fait au rythme que le facteur d'échelle. Les deux se compensent, donnant un rayon comobile constant.

Le calcul du rayon de l'univers observable

modifierDans ce modèle, calculer le rayon de l'univers observable n'est pas une mince affaire. On a vu dans le chapitre sur l'univers observable qu'il faudrait idéalement utiliser cette formule :

Malheureusement, si on se met à faire les calculs à la main, on s’aperçoit rapidement que l'intégrale ne converge pas ! Le modèle nous dit donc que le rayon observable de l'univers est infini. Cela est un avantage, car cela résout un problème majeur, appelé problème de l'horizon, qui touche les autres modèles cosmologiques. Nous en reparlerons vers la fin du cours plus en détail.

Le calcul du décalage vers le rouge

modifierDans ce qui suit, nous allons supposer qu'un objet à une distance émet de la lumière à un instant , lumière qui est reçue par l'observateur à un instant . Nous allons calculer le décalage vers le rouge de cette lumière, le redshift. Pour gérer ce cas, nous allons devoir utiliser la formule suivante, vue dans le chapitre sur le rayonnement, qui donne le redshift en fonction du facteur d'échelle :

On injecte alors l'équation :

En simplifiant, on trouve :

Il est aussi possible d'écrire le facteur de Hubble en fonction du décalage vers le rouge et réciproquement. Par exemple, imaginons qu'un objet émette de la lumière à un instant , quand le facteur de Hubble est égal à et le facteur d'échelle à . Sa lumière est reçue par l'observateur à l'instant , quand le paramètre de Hubble et le facteur d'échelle valent et . On peut alors démontrer l'équation suivante :

Qui peut se reformuler comme suit :

|

Démonstration |

|

Pour démontrer la formule précédente, partons de la relation : Or, on sait que . On a donc et En faisant le remplacement dans l'équation précédente, on trouve : En réarrangeant les termes, on trouve la formule à démontrer, mais sous une forme légèrement différente : |

Un modèle trop simplifié pour être réaliste

modifierLes scientifiques ont estimé le rayon de l'univers observable, et leurs résultats semblent relativement proches du rayon de Hubble. Là encore, comme pour la coïncidence entre âge de l'univers estimé et temps de Hubble, personne ne sait si c'est une coïncidence ou quelque chose de plus important. En théorie, l'égalité est respectée en permanence dans le modèle linéaire. Par contre, elle n'est respectée que pour un instant bien précis dans les autres et violée dans tous les autres cas. Le fait que l'égalité soit respectée dans notre monde est donc soit une grosse coïncidence, soit elle trahit quelque chose de fondamental qui est encore mal compris. Par contre, les résultats empiriques concernant les mesures de redshift, ou via d'autres mesures indirectes, ne collent pas du tout avec ce modèle. Autant l'égalité est respectée, autant les autres prédictions du modèle ne le sont pas.

Et les mesures ne sont pas seules à nous dire que ce modèle est trop simpliste pour décrire fidèlement l'univers. La théorie nous dit que ce modèle n'est valide que pour un univers vide, c'est à dire en absence de matière. Toute présence de matière biaise les résultats du modèle[3]. Et aux dernières nouvelles, la matière existe...

Le modèle à croissance en loi de puissance

modifierMaintenant, nous allons étudier le cas d'une expansion en loi de puissance. En clair, nous allons étudier le cas où le facteur d'échelle est égal à :

- , avec le temps, une constante quelconque et une puissance quelconque.

Une autre formulation, souvent utilisée, est la suivante :

- , avec l'origine de temps choisie arbitrairement et le facteur d'échelle à ce même instant.

Les deux formulations sont équivalentes si l'on postule . Dans ce qui suit, nous utiliserons la première formulation.

- On peut d'or et déjà remarquer que l'expansion linéaire n'est qu'un cas particulier d'expansion en loi de puissance, où . Ne vous étonnez donc pas si les calculs se ressemblent quelque peu.

Le calcul du facteur de Hubble et des paramètres associés

modifierPour calculer le facteur de Hubble, nous allons partir de la dérivée du facteur d'échelle, qui est égale à :

On divise alors par a(t) pour obtenir le facteur de Hubble :

Pour résumer :

L'évolution du facteur de Hubble

modifierPour savoir comment évolue le facteur de Hubble dans le temps, le mieux est encore une fois de calculer sa dérivée. La dérivée du facteur de Hubble est égale à :

On pourrait croire qu'elle est négative, en raison du signe -, mais tout dépend de la valeur de n. C’est le cas si n est positif ou nul, mais il peut être négatif.

Le calcul du paramètre de décélération

modifierÀ partir des résultats précédents, on peut calculer la valeur du paramètre de décélération. Pour le calculer, on applique la formule suivante, vue dans le chapitre sur l'univers observable :

On injecte l'équation dans l'équation précédente, ce qui donne :

On injecte alors l'équation , ce qui donne :

Ce qui se simplifie en :

On peut réécrire le tout comme suit :

En clair, l'expansion dépend du coefficient .

- Si , alors on retombe sur le cas de l'expansion linéaire. L'expansion a un rythme constant : elle n’accélère pas et ne ralentit pas.

- Si , l'expansion accélère.

- Enfin, si , l'expansion de l'univers ralentit.

Le calcul de l'âge de l'univers

modifierL'équation : permet de calculer l'âge de l'univers à partir du facteur de Hubble. En isolant dans l'équation précédente, on trouve en effet :

Reformulons en utilisant le temps de Hubble :