Électronique/Version imprimable

Une version à jour et éditable de ce livre est disponible sur Wikilivres,

une bibliothèque de livres pédagogiques, à l'URL :

https://fr.wikibooks.org/wiki/%C3%89lectronique

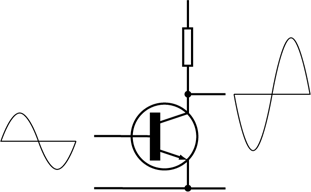

Les amplificateurs électriques

Dans ce chapitre, nous allons étudier les amplificateurs opérationnels, à savoir les composants qui amplifient une tension ou un courant. Il en existe de nombreux types, mais tous sont des quadripôles (pour rappel, des composants avec quatre broches) : deux broches servent d'entrée et reçoivent une tension ou un courant, alors que les deux autres fournissent une tension ou un courant en sortie. On distingue les amplificateurs selon qu'ils amplifient la tension d'entrée, le courant, ou la puissance.

- Pour une amplification en tension, la tension de sortie est un multiple de celle d'entrée.

- Pour une amplification en courant, le courant fournit en sortie est un multiple de celui envoyé sur l'entrée.

- Certains amplificateurs font à la fois de l'amplification de tension et de courant : on parle d'amplification de puissance.

La relation entre tension d'entrée et de sortie

modifier

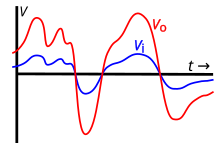

À noter que si l'entrée et la sortie sont proportionnelles, courants et tension de sortie ne peuvent cependant pas dépasser une valeur maximale (souvent proche de la tension ou du courant d'alimentation). Le schéma ci-contre illustre la relation entre entrée et sortie, dans le cas d'un amplificateur en tension. On voit qu’en-deça d'une certaine tension d'entrée, tension d'entrée et de sortie sont proportionnelles. On dit alors que l'amplificateur est en régime linéaire, ce qui trahit la relation entre entrée et sortie. Mais au-delà d'une certaine tension d'entrée, la tension de sortie sature et reste à sa valeur maximale, quelle que soit la tension d'entrée. On dit que l'amplificateur est en régime de saturation, ce qui trahit le fait que la tension de sortie "sature".

Le régime linéaire : gain et transmittance

modifierCommencons par étudier le régime linéaire, le régime non-linéaire étant pour plus tard. Si l'on envoie une tension sinusoïdale sur l'entrée d'un amplificateur, la sortie fournit une tension sinusoïdale de même fréquence, mais dont la phase et l'amplitude peuvent être différentes (même chose pour un courant, mais nous utiliserons des tensions dans ce qui suit, pour simplifier les explications). On peut calculer le rapport entre la tension d'entrée et la tension de sortie . Celui-ci s'appelle la fonction de transfert, bien que le terme transmittance soit aussi très utilisé, et se note . La transmittance d'un amplificateur n'est évidemment pas la même selon la fréquence, ce qui traduit le fait que certaines fréquences sont atténuées et d'autres amplifiées. Voici sa formule de calcul.

Si on utilise des phaseurs pour les tensions d'entrée et de sortie, leur rapport est un nombre complexe, qui dépend de la fréquence du signal d'entrée/sortie. La transmittance ainsi calculée est appelée la transmittance complexe et se note .

Vu qu'il s'agit d'un nombre complexe, la transmittance possède un module et un argument, dont les interprétations sont les suivantes :

- L'argument est le déphasage entre signal de sortie et d'entrée.

- Le module est le rapport entre amplitudes d'entrée et de sortie. Il porte le nom d'amplification. Elle n'est évidemment pas la même selon la fréquence, ce qui traduit le fait que certaines fréquences sont plus amplifiées que d'autres.

Il est fréquent d'utiliser des diagrammes qui relient l'amplification/atténuation à la fréquence. Analyser ces diagrammes est cependant assez compliqué si l'on utilise une échelle linéaire. Par exemple, la courbe tracée par un simple condensateur ou une bobine donnent une courbe exponentielle. Pour éviter un tel écueil, il est d'usage d'utiliser une courbe logarithmique, histoire que l'amplification causée par les récepteurs non-linéaires (condensateur et bobine) donnent des droites. Pour cela, on calcule une fonction dérivée du logarithme de l'amplification : le gain. Celui-ci vaut :

Les non-linéarités : distorsion et bruit

modifier

Un amplificateur n'est pas un composant parfait et sa linéarité n'est qu'une approximation. Dans le monde réel de la réalité véritable, les amplificateurs ont de petites imperfections qui rendent la relation sortie-entrée non-linéaire. Dans la plupart des cas, cette non-linéarité est négligeable et ne se ressent pas. Mais pour certaines applications ou certains signaux, la non-linéarité devient sensible et commence à poser des problèmes. Les sources de non-linéarité sont variables, mais leur résultat est le même : le signal d'entrée et le signal de sortie n'ont pas la même forme. Cela veut dire que si l'on envoie une sinusoïde en entrée, la sortie n'est plus une sinusoïde. Le signal subit ce qu'on appelle une distorsion. À la distorsion, il faut ajouter du bruit, à savoir des variations aléatoires du signal de sortie, causé par divers mécanismes physiques.

Le premier type de distorsion est lié au fait que des sinusoïdes de fréquences différentes ne sont pas amplifiées de la même manière (certaines le sont plus que d'autres). Or, le théorème de Fourier nous dit que tout signal est composé d'une somme de sinusoïdes et de cosinusoïdes. Si les différentes sinusoïdes d'un signal ne sont pas amplifiées de la même manière, le signal de sortie ne ressemblera pas au signal d'entrée. Ce phénomène est appelé la distorsion d'amplitude. La distorsion de phase est similaire, sauf que la phase des sinusoïdes est décalée par l'amplificateur, chaque sinusoïde l'étant d'une manière différente. Les différentes sinusoïdes se déphasent progressivement, ce qui fait que le signal d'entrée ne ressemble plus au signal de sortie. Ces deux formes de distorsion ont une même cause : la transmittance varie selon les fréquences (que ce soit son module ou son argument). Une conséquence est que ces distorsions ne touchent pas les sinusoïdes pures : un signal sinusoïdal en entrée donne une sinusoïde en sortie. Seuls les signaux complexes, avec des harmoniques, sont déformés et distordus.

En temps normal, pour des entrées assez faibles, la saturation ne pose pas de problèmes. Mais si l'entrée devient trop importante, la sortie sature. Par exemple, prenons le cas d'un signal sinusoïdal, qu'on envoie en entrée d'un amplificateur. Si le signal d'entrée est assez faible, la tension d'entrée restera dans le régime linéaire et la tension de sortie est elle aussi une sinusoïde. Mais si le signal d'entrée est assez importante, elle peut passer dans le régime de saturation : la sortie ne donne alors pas une sinusoïde, mais un signal déformé du fait de la saturation. Ce phénomène porte un nom : on l'appelle la distorsion harmonique.

Les catégories d'amplificateurs selon leur étage de sortie

modifier

Il existe de nombreuses classifications pour les amplificateurs électroniques, qui catégorisent ceux-ci selon des critères assez variés. L'une d'entre elle se base sur ce qu'il advient du signal en sortie de l'amplificateur, quand on envoie un signal sinusoïdal sur l'entrée différentielle. Le signal de sortie peut alors être : soit sinusoïdal, soit ne conserver que les tensions positives (ou négatives), soit ne garder que les tensions au-delà d'une tension seuil positive ou négative. Cela donne quatre classes principales, appelées classes A, B, AB et C. Il existe des classes plus marginales, appelées D, E, F, G, et encore d'autres, mais nous les aborderons pas ici. Les quatre classes A, B, AB et C sont illustrées ci-contre et ci-dessous.

- Les amplificateurs de classe A donnent un signal non-déformé en sortie : une sinusoïde en entrée reste une sinusoïde.

- Les amplificateurs de classe B ne gardent que les tensions positives (ou négatives, selon l'amplificateur) et mettent à zéro la tension quand l'entrée devient négative (réciproquement positive).

- Les amplificateurs de classe AB et C mettent la tension de sortie à zéro quand elle dépasse un seuil de tension. La différence est que :

- les amplificateurs de classe AB ont une tension de seuil négative ;

- les amplificateurs de classe C ont une tension de seuil positive.

|

|

|

|

On peut reformuler les classes précédentes en se basant sur la durée durant laquelle l'amplificateur amplifie réellement le signal. Partons du principe qu'on envoie une sinusoïde de période P sur l'entrée. Les amplificateurs n'amplifient le signal que sur une portion précise de la période (sauf les amplificateurs de classe A, qui amplifient tout le temps). Quand ils mettent la sortie à 0, ils ne l'amplifient pas. On peut alors dire que tel amplificateur amplifie le signal durant 50% de la période, tel autre durant 100%, celui-ci à peine 20% de la période P, etc.

- Un amplificateur de classe A amplifie le signal sur 100% de la période du signal d'entrée.

- Un amplificateur de classe B amplifie le signal sur 50% de la période du signal d'entrée (quand la tension est positive sur certaines amplificateurs, ou négative sur d'autres).

- Un amplificateur de classe AB amplifie le signal pour une durée comprise entre 50 et 100% de la période du signal d'entrée.

- Un amplificateur de classe C amplifie le signal pour une durée comprise entre 0 et 50% de la période du signal d'entrée.

| Classe | % de période | Description |

|---|---|---|

| Classe C | 0-50% | Amplifie durant une fraction de la demi-période positive/négative (selon l'amplificateur). |

| Classe B | 50% | Amplifie durant la demi-période positive/négative (selon l'amplificateur). |

| Classe AB | 50-100% | Amplifie durant la demi-période positive/négative (selon l'amplificateur) et une fraction de l'autre demi-période. |

| Classe A | 100% | Amplifie durant toute la période. |

Les amplificateurs opérationnels

Dans le chapitre précédent, nous avons vu les amplificateurs, au sens général du terme. Dans ce chapitre, nous allons voir une classe particulière d'amplificateurs : les amplificateurs opérationnels (AOP). Ils sont très utilisés de nos jours, et l'étaient encore plus du temps des calculateurs analogiques, avant l’invention de l'informatique. De nos jours, ils sont à la base de presque tous les circuits analogiques, que ce soit les régulateurs de tension, les oscillateurs électriques, les générateurs de fréquence, les servomoteurs (des circuits qui commandent un moteur) et bien d'autres. Ils sont formés de transistors, de résistances, ou d'autres composants du genre, mais on ne se préoccupera pas de ce qu'il y a à l'intérieur pour le moment.

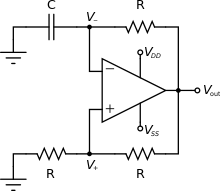

Un AOP a plusieurs broches : des broches d'alimentation symétriques par rapport à la masse sur lesquelles placer VCC et son inverse (-VCC), une sortie (ce qui est normal) et deux entrées (ce qui est moins intuitif). Il existe deux symboles pour représenter les AOPs : un dit américain et un autre dit européen. Les deux notations sont données dans le schéma ci-dessous.

L'AOP réel

modifierLa présence de deux entrées s'explique par le fait qu'un AOP est ce que l'on appelle un amplificateur différentiel : il amplifie la différence entre deux tensions. Il prend les deux tensions d'entrée, soustrait la seconde à la première, et amplifie le résultat. Le coefficient d'amplification est appelé le gain différentiel de l'AOP, ou encore le gain en boucle ouverte. Si les deux tensions sont égales, l'AOP fournit une tension nulle, propriété appelée rejet du mode commun. Les tensions sur les deux broches d'entrée sont notées et , alors que la tension de sortie est notée . Pour un AOP, on a :

- , avec le gain différentiel de l'amplificateur.

|

|

La relation entre entrées et sortie

modifierUn AOP présente quelques propriétés qui sont des défauts pour l'électronicien. Pour comprendre ces défauts, nous allons voir en premier lieu les défauts qui apparaissent en courant continu. Nous allons repartir de l'équation vue plus haut, qui décrit le fonctionnement idéal d'un AOP et l’améliorer pour rendre compte de ces défauts :

- , avec le gain différentiel de l'amplificateur.

Un premier défaut est que, pour , la tension de sortie est non-nulle. La tension de sortie obtenue sous ses conditions, à savoir quand les deux entrées sont mises à la masse, est appelée la tension d'offset. Elle peut être positive ou négative : tout dépend de l'AOP utilisé. En temps normal, elle vaut entre 1 mV et 5 mV, guère plus. Elle a pour origine la structure interne de l'AOP, qui est composé de transistors et de composants passifs, qui sont loin d'être parfaits. Notons que la tension d'offset peut varier selon la température, ce qui fait qu'elle est souvent difficile à corriger via un circuit quelconque.

- , avec la tension d'offset.

Ensuite, il faut ajouter l'influence de la tension en mode commun (la moyenne arithmétique des deux tensions d'entrée). Celle-ci est aussi amplifiée et se retrouve dans la tension de sortie. Le coefficient d'amplification lié à la tension en mode commun est appelée le gain en mode commun.

- , avec le gain en mode commun.

Si on note la tension différentielle et la tension en mode commun , on a une version plus simple de l'équation qui est :

| Mesure du gain en mode commun |

|---|

| Si on place la même tension sur les deux entrées et , on a :

En prenant une tension de 1 Volt, la tension de sortie est égale au gain en mode commun. |

| Mesure du gain différentiel |

| Si on place une tension sur une borne et son opposée sur l'autre, on a alors :

En utilisant une tension de 0,5 Volts, la sortie est égale au gain en mode différentiel. |

On peut reformuler l'équation en utilisant une grandeur appelée le taux de rejet en mode commun, qui est égal à :

On a alors :

Les impédances et courants d'entrée/sortie

modifier

Les entrées d'un AOP réel sont traversées par un courant, même quand on n'y place aucune tension dessus. Si on place les deux entrées à la masse, on observera un courant d'entrée sur l'entrée et un autre sur l'entrée , qui seront notés et . Les électroniciens utilisent la moyenne de ces deux courants, , auxquels ils donnent le nom de courant de polarisation. Ils utilisent aussi la différence entre ces deux courants, , qui porte le nom de courant d'offset.

Enfin, précisons que l'AOP réel dispose d'une impédance de sortie non-nulle, ainsi que de plusieurs impédances d'entrée (une par entrée et une pour la liaison entre les deux). Le schéma ci-dessous montre quelles sont ces impédances et comment elles sont reliées aux différentes entrées. On voit qu'il existe une impédance pour chaque entrée, qui relie celle-ci à la masse. On trouve aussi une impédance d'entrée située entre les deux entrées, qui porte le nom d'impédance d'entrée différentielle. Chaque impédance d'entrée est constituée d'une résistance en parallèle avec un condensateur, ce qui a des implications sur le fonctionnement de l'AOP à haute fréquence. Mais laissons cela pour plus tard.

La bande passante d'un AOP

modifierEn courant alternatif, d'autres défauts font leur apparition. Le premier d'entre eux est que le gain différentiel varie avec la fréquence. Plus précisément, le gain différentiel diminue quand la fréquence augmente, les exceptions étant très rares. On peut mettre cela en équation assez simplement, avec la formule suivante (que nous étudierons plus en détail dans le chapitre sur les filtres électroniques) qui exprime la gain en nombre complexe :

- , avec le gain en courant continu (f = 0), f la fréquence du signal d'entrée, et une fréquence particulière appelée fréquence de coupure.

Qui plus est, le gain et la fréquence de coupure sont reliés entre eux : plus le gain est grand, plus la fréquence de coupure sera basse. Pour le dire autrement, la bande passante d'un AOP varie selon le gain configuré.

|

|

La vitesse de balayage

modifier

Un autre défaut se manifeste pour des signaux de fréquence élevée : l'amplificateur n'arrive pas à suivre le signal d'entrée, qui va trop vite pour lui. La raison est que la tension de sortie ne peut pas augmenter soudainement et met un certain temps avant d'atteindre la valeur voulue. Si on place un front de tension (la tension passe immédiatement de 0 à 5 Volts, par exemple), la tension de sortie va monter progressivement et former une sorte de rampe, comme illustré ci-contre. Pour résumer, les variations de la tension de sortie ne sont pas instantanées. La vitesse à laquelle la tension de sortie évolue est appelée la vitesse de balayage (slew rate en anglais). Elle est définie par :

Si la tension d'entrée évolue plus vite que la vitesse de balayage (en clair, si ), le signal de sortie est alors déformé. Pour un signal sinusoïdal, cela arrive au-delà d'une certaine fréquence. Pour la calculer, prenons ce signal :

On a alors la dérivée suivante :

La vitesse maximale du signal est donc de . Si la vitesse de balayage est inférieure à cette valeur maximale, le signal sera déformé. Alors qu'il ne subira pas de distorsion liée à la vitesse de balayage dans le cas contraire. On sait donc que la fréquence maximale est celle pour laquelle :

- , avec la vitesse de balayage.

Ce qui donne :

L'AOP idéal (parfait)

modifierL'AOP réel est un circuit très complexe, dont les propriétés ne sont pas forcément importantes quand on étudie des circuits électroniques. Pour se simplifier la vie, les électroniciens utilisent un modèle simplifié d'AOP appelé AOP parfait, ou encore AOP idéal. Un tel AOP respecte plusieurs conditions irréalistes, mais qui permettent de simplifier l'étude de nombreux circuits électroniques. Celui-ci diffère de l'AOP réel sur de nombreux points. Bon nombre des propriétés de l'AOP réel sont négligées dans l'AOP idéal, ce qui simplifie les calculs et l'analyse. Dans cette section, nous allons voir en quoi l'AOP parfait diffère de l'AOP réel.

Pour rappel, les propriétés principales de l'AOP réel sont résumées dans le schéma de droite. Elles regroupent :

- Des impédances d'entrée assez fortes.

- Une impédance de sortie faible, mais non-nulle.

- Des courants de sortie et d'entrée liés aux impédances précitées.

- Une tension d'offset (non-représentée sur le schéma ci-contre).

- Un gain en mode commun faible, mais non-nul.

- Un gain différentiel assez important, qui diminue avec la fréquence.

- Une vitesse de balayage finie (non-représentée sur le schéma ci-contre).

Les simplifications de l'AOP parfait

modifierUne première simplification est de négliger les impédances d'entrée et de sortie. Sur un AOP réel, les impédances d'entrée sont très grandes, alors que l'impédance de sortie est très faible. Pour donner quelques chiffres, l'impédance d'entrée d'un AOP réel est comprise entre et Ohms, ce qui est énorme. Dans ces conditions, on peut considérer que l'impédance est infinie. En clair, les entrées se comportent comme des morceaux de fils non-reliés au reste du circuit interne de l'AOP : il n'y a pas de courants d'entrée. On peut aussi négliger l'impédance de sortie, qui est très faible. Pour un AOP réel, elle est comprise entre 10 et 500 Ohms, rarement plus. Autant ne pas en tenir compte dans les calculs et la supposer nulle. À noter que cette simplification vaut tant que l'on relie l'AOP à des résistances de l'ordre du millier d'Ohm ou plus.

Une autre simplification est de négliger le gain en mode commun et la tension d'offset. La tension de sortie d'un tel AOP est toujours égale à , sans que le courant de sortie ait une quelconque importance. Un AOP est donc une source de tension parfaite, sans impédances parasites. Il est aussi d'usage de supposer que le gain d'un AOP parfait est très grand, suffisamment grand pour être infini. Cela veut dire que la tension de sortie sature entre la tension d'alimentation et son opposé. La caractéristique / d'un AOP parfait est illustrée ci-dessous.

Enfin, le gain différentiel est supposé identique pour toutes les fréquences, ce qui fait qu'il a une bande passante infinie.

Résumé

modifierLes propriétés d'un AOP réel et d'un AOP idéal sont comparées ci-dessous. Toutes ces simplifications permettent de simplifier l'étude des circuits qui vont suivre.

| Propriété | AOP idéal | AOP réel |

|---|---|---|

| Impédance d'entrée | Infinie | Finie |

| Impédance de sortie | Nulle | Non-nulle |

| Vitesse de balayage (slew rate) | Infinie | Finie, non-négligeable |

| Bande passante | Infinie | Finie |

| Gain différentiel | Infini (ou du moins très grand) | Fini, non-négligeable |

| Gain en mode commun | Nul | Non-nul |

| Tension d'offset | Nulle | Non-nulle |

La rétroaction linéaire et l'amplification

Les AOP sont rarement utilisés seuls, mais sont souvent utilisés dans des circuits qui combinent un AOP avec des résistances, des bobines, des condensateurs, ou d'autres composants passifs. Dans beaucoup de cas, la sortie de l'AOP est envoyée dans un circuit passif, qui lui-même est relié à l'entrée. Ce genre de circuit est un cas particulier de ce qu'on appelle des circuits à rétroaction. Ce sont des circuits dans lesquels la sortie du circuit est traitée, puis renvoyée sur l'entrée. Renvoyer la sortie sur l'entrée est ce qu'on appelle une rétroaction, d'où le nom donné à ces circuits. En soit, la rétroaction peut s'utiliser pour des raisons très différentes.

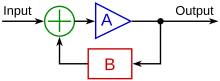

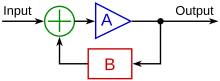

Les circuits à rétroaction ont une forme illustrée ci-dessous. La tension d'entrée est notée X(s) et la tension de sortie est notée Y(s). On voit qu'il y a deux circuits distincts. Le premier circuit transforme l'entrée X(s) en sa sortie Y(s) et il a une transmittance notée G(s). Nous l’appellerons le circuit direct, car il connecte directement l'entrée à la sortie. Le second circuit, de transmittance H(s), traite la sortie et renvoie son résultat sur l'entrée. Nous l’appellerons le circuit de rétroaction. Il existe deux types de rétroaction, suivant comment on traite le résultat du circuit de rétroaction. Avec la rétroaction positive, l'entrée est additionnée au signal de rétroaction. Avec la rétroaction négative, le signal de rétroaction est soustrait du signal d'entrée.

Dans ce qui suit, nous allons supposer que le circuit direct et le circuit de rétroaction sont des circuits linéaires, c'est à dire que la sortie et l'entrée sont proportionnels. Le circuit direct multiplie son entrée par un coefficient , alors que le circuit de rétroaction multiplie sa sortie par . Le coefficient est appelé le gain en boucle ouverte et correspond ni plus moins qu'au gain de l'amplificateur. Il est à différencier du gain du circuit complet, qui est défini par le rapport entre entrée et sortie du circuit, soit Y(s)/X(s). Ce dernier est appelé le gain en boucle fermée. Les noms gain en boucle fermée et gain en boucle ouverte parlent d'eux-mêmes : le premier est mesuré sans la rétroaction, donc avec la boucle ouverte, alors que le second est mesuré avec le circuit de rétroaction, donc quand la boucle est fermée.

Dans ce chapitre, nous allons voir comment fonctionnent les circuits à rétroaction de manière générale. Nous verrons dans le chapitre suivant quels montages on peut obtenir avec une rétroaction simple. Nous utiliserons aussi les acquis de ce chapitre dans les chapitres sur les filtres et les oscillateurs. Dans ce qui va suivre, nous allons voir la rétroaction négative avant de voir la rétroaction positive.

La rétroaction négative

modifierAvec la rétroaction négative, le résultat de la rétroaction est soustrait au signal d'entrée. Dans le cas des AOP, elle peut servir à corriger les défauts de l'AOP utilisé. Cela peut permettre de rendre le gain moins sensible aux défauts de l'AOP, à augmenter la bande passante, à réduire l'effet du bruit et des perturbations, à réduire les distorsions non-linéaires, où à modifier les résistances d'entrée et de sortie. Mais, si elle est utilisée intelligemment, elle permet de créer des circuits complexes en utilisant un AOP central. On peut ainsi créer des filtres, des oscillateurs ou des circuits additionneur/soustracteurs/multiplieurs/intégrateur/dérivateurs/autres.

Un circuit à rétroaction négative a la forme donnée ci-dessous. Il prend un signal d'entrée (Signal) et fournit un signal de sortie (Output), le signal de rétroaction est noté .

Le signal O(s) est multiplié par par le circuit de rétroaction, ce qui donne :

Le signal d'entrée S se voit soustrait le signal de rétroaction R, de qui donne un résultat temporaire I qui vaut :

Ce dernier est amplifié par l'AOP, qui a un gain , ce qui donne une sortie égale à :

La transmittance d'un circuit à rétroaction

modifierMaintenant, reprenons l'équation précédente et développons.

Divisons par S :

Par définition, n'est autre que la transmittance du circuit complet. En notant celle-ci , on a :

Regroupons les termes avec la transmittance :

Factorisons la transmittance :

Et isolons la transmittance :

Le terme est appelé le gain de boucle. Pour que la rétroaction soit négative, il faut que celui-ci soit positif. Le terme , au dénominateur de la transmittance est appelé la quantité de rétroaction.

|

Le circuit illustré a une transmittance égale à . |

Au passage, dans la plupart des applications, on a . Dans de telles conditions, la transmittance devient :

Cela signifie que le comportement du circuit est totalement déterminé par le circuit de rétroaction, pas par l'amplificateur. Cela ne signifie pas que le circuit direct est inutile, mais que la sortie sera peu sensible au gain de l'AOP central.

Usage de la rétroaction négative

modifierMaintenant, nous allons voir quels sont les avantages de la rétroaction négative, ce à quoi elle peut servir.

Une augmentation de la bande passante

modifierLa rétroaction négative augmente la bande passante de l'AOP. Notons que cette augmentation de la bande passante est proportionnelle à la réduction du gain en boucle fermée. Plus le gain en boucle fermée est réduit, par rapport au gain en boucle ouverte, plus la bande passante sera élargie. On peut prouver, à partir de résultats mathématiques non-triviaux, que le produit bande passante gain est une constante. En conséquence, une réduction de x% du gain en boucle fermée se traduira par une augmentation de x% de la bande passante.

Traditionnellement, on étudie le cas où le gain de l'AOP diminue avec la fréquence. Le gain de l'amplificateur dépend de la fréquence en suivant l'équation suivante :

On peut alors combiner cette équation avec la formule de la transmittance . On obtient alors :

En simplifiant, on a :

La situation étudiée est illustrée dans le schéma ci-dessous.

Réduction de la sensibilité à l'AOP du gain

modifierLa première utilisation est la réduction du gain du circuit, de sa sensibilité au gain de l'AOP. Une variation massive du gain de l'AOP se traduit par une réduction beaucoup plus faible du gain du circuit total. Pour comprendre en quoi, partons de la transmittance du circuit à rétroaction :

Dérivons l'équation précédente, pour voir comment le gain varie.

Divisons par la transmittance :

Le terme correspond à une modification en pourcentage du gain en boucle fermée, alors que le terme est une variation en pourcentage du gain en boucle ouverte. On voit que le terme est le coefficient de proportionnalité entre les deux gains en boucle fermée et ouverte. Ce terme est généralement plus petit que 1, beaucoup plus petit. Le gain en boucle fermée du circuit est donc stabilisé, il dépend peu du gain en boucle ouverte de l'AOP.

La réduction des interférences

modifierUne autre utilité de la rétroaction est qu'elle permet de réduire l'intensité des perturbations extérieures. Pour comprendre pourquoi, imaginons qu'une perturbation D survienne et perturbe la sortie. Intuitivement, le circuit de rétroaction amplifiera la perturbation D et le signal de rétroaction sera de . Le signal intermédiaire I est donc amputé de , ce qui fait que la sortie est approximativement réduite de . Si on , alors la perturbation est supprimée immédiatement après son apparition. Il suffit que la distorsion se propage dans le circuit de rétroaction, puis dans l'AOP central, et la sortie revient à la normale.

Au niveau mathématique, on peut comparer ce qui se passe avec une perturbation D, avec et sans rétroaction.

Si la rétroaction n'avait pas d'effet sur la perturbation, alors la perturbation s'ajouterait à la sortie directement. Ce qui fait que l'on aurait :

Or, les calculs nous disent qu'avec la perturbation, le circuit à rétroaction négative a une sortie égale à :

|

Démonstration |

|

Pour cela, on suppose que la perturbation s'ajoute à la sortie de l'AOP, pour donner la sortie. En clair, on a :

On combine alors avec On développe : On regroupe les termes avec O : On factorise O : On divise par : |

On voit que l'effet de la perturbation est multiplié par , qui est généralement inférieur à 1. En clair : l'effet de la perturbation est réduit du fait de la rétroaction. Si jamais une interférence électromagnétique peu intense survient, un circuit à rétroaction se comportera normalement. Sa sortie restera relativement stable et ne sera pas trop perturbée par la perturbation.

La rétroaction positive

modifierUn circuit à rétroaction positive est identique au circuit à rétroaction négative, sauf que le signal de rétroaction est ajouté au signal d'entrée. Dans ces conditions, on a :

Développons l'équation précédente :

Divisons par S pour obtenir la transmittance :

Regroupons les termes avec la transmittance :

Factorisons la transmittance :

Et isolons la transmittance :

Effets de la rétroaction positive

modifierLa rétroaction positive a divers effets que nous allons aborder ici.

Réduction de la sensibilité à l'AOP du gain

modifierComme pour la rétroaction négative, la rétroaction positive tend à réduire la sensibilité du gain en boucle fermée au gain en boucle ouverte. Pour le prouver, reprenons le gain en boucle fermée :

Dérivons l'équation précédente et divisons par la transmittance :

Comme pour la rétroaction négative, le terme est un coefficient de proportionnalité qui relie les gains en boucle fermée et ouverte. Ce terme est généralement plus petit que 1, ce qui fait le des variations du gain en boucle ouverte n'ont que peu d'effet sur le gain en boucle fermée.

Réduction de la bande passante

modifierContrairement à la rétroaction négative, la rétroaction positive réduit la bande passante. Il faut dire que l'augmentation du gain doit forcément se traduire par une réduction de la bande passante, du fait de la constante du produit gain bande passante.

Amplification des perturbations

modifierUn autre défaut est que la rétroaction positive augmente l'effet des perturbations. Pour le montrer, procédons comme auparavant et ajoutons une perturbation sur la sortie du circuit. Comparons maintenant le résultat avec et sans la rétroaction.

Sans la rétroaction, le circuit a une sortie égale à :

Or, les calculs nous disent qu'avec la perturbation, le circuit à rétroaction positive a une sortie égale à :

|

Démonstration |

|

Pour cela, on suppose que la perturbation s'ajoute à la sortie de l'AOP, pour donner la sortie. En clair, on a :

On combine alors avec On développe : On regroupe les termes avec O : On factorise O : On divise par : |

On voit que les perturbations sont amplifiées, du fait du terme .

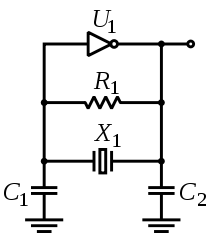

La stabilité d'un circuit à rétroaction négative

modifierIl existe des valeurs de pour lesquelles la transmittance peut s'annuler ou au contraire devenir infinie. La transmittance est toujours écrite sous la forme d'une fraction avec un numérateur et un dénominateur. Elle s'annule si le numérateur est égal à 0, alors qu'elle devient infinie/indéfinie si le dénominateur s'annule. Les valeurs pour lesquelles sont appelées les zéros de la transmittance, alors que celles où sont appelées des pôles. Si la présence de zéros n'est pas en soi un problème, la présence de pôle en est un. Dans un cas pareil, le circuit est dit instable. On pourrait croire que les pôles n'ont pas de signification physique. Mais il n’en est rien ! Il est parfaitement possible de créer des circuits avec des pôles. En effet, certains oscillateurs (des générateurs de fréquences) sont fabriqués en utilisant cette possibilité. Concrètement, sur un pôle, la sortie du circuit est finie et non-nulle alors que l'entrée est nulle. Dans la plupart des cas, le circuit se met à osciller, à savoir que sa sortie est une tension sinusoïdale ou tout du moins une tension périodique. Ce n'est pas systématique, mais c'est une possibilité, tout dépend du circuit.

Si on compare les circuits à rétroaction positive et négative, on voit que les pôles surviennent pour des valeurs différentes de . Rappelons que pour le dénominateur est égal à et , respectivement. Pour un circuit à rétroaction négative, un pôle correspond au cas où . Cela demande que la condition suivante soit respectée : . Pour un circuit à rétroaction positive, il faut que la quantité de rétroaction s'annule, ce qui arrive si . Cela demande que la condition suivante soit respectée : .

Un problème similaire survient si la transmittance devient négative. Le cas est un petit peu plus complexe, mais le circuit est là aussi instable. Dans ce cas, la transmittance reste finie, mais la tension de sortie a quelques propriétés bizarres. Les méthodes classiques d'analyse des circuits linéaires ne fonctionnent pas et il faut utiliser d'autres méthodes d'analyse spécifiques. Les circuits qui fonctionnent avec cette condition sont les circuits oscillateurs, comme les multivibrateurs, les circuits bistables, etc. Cela arrive si devient négatif, pour un circuit à rétroaction négative. Pour un circuit à rétroaction positive, il faut que . Avec cette condition, la quantité de rétroaction est négative et la transmittance aussi.

En théorie, il suffirait de choisir et pour éviter un tel cas d'instabilité. C'est simple à faire si les deux coefficients ne dépendant pas de la fréquence et sont des constantes. Mais dans la réalité, les AOP et circuits linéaires ne se comportent pas ainsi. Dans la réalité, les circuits ont une transmittance qui dépend de la fréquence. Et il est possible que, pour certaines fréquences, on ait . Il faut absolument éviter ce cas de figure lors de la conception du filtre. Pour cela, il existe quelques techniques, dont l'usage du critère de Nyquist, qui permettent de détecter la présence d'une instabilité ou son absence. L'analyse de la stabilité d'un circuit à rétroaction positive se fait avec les mêmes outils que pour un circuit à rétroaction négative, avec quelques petites différences mineures (la valeur de n'est pas la même pour obtenir un pôle).

Le diagramme de Nyquist

modifierLe diagramme de Nyquist est relativement simple. Il s'agit d'une courbe dessinée dans le plan complexe. Rappelons que la transmittance est un nombre complexe, son module correspondant au rapport entre tension d'entrée et de sortie, alors que l'argument donne le déphasage entre les deux tensions. Mais contrairement à ce que l'on peut penser, on ne trace par la transmittance du circuit sur ce diagramme, ce qui ne nous permettrait pas de détecter les situations où elle devient infinie. À la place, chaque point de la courbe est associée au produit mesuré à une fréquence, différente en chaque point.

Pour un circuit à rétroaction, le circuit devient instable pour une valeur finie de , ce qui peut se voir sur le plan complexe. Rappelons que la valeur est égale à -1 pour un circuit à rétroaction négative. La courbe dessinée sur le diagramme de Nyquist donne donc toutes les valeurs possibles de ce produit, et l'on peut vérifier si la courbe passe par -1. Si le circuit peut être instable, alors il passe forcément par le point de coordonnées (-1,0).

|

|

|

La réponse impulsionnelle d'un circuit à rétroaction

modifierPrécisons maintenant comment se comporte un circuit suivant ce que l'on voit sur le diagramme de Nyquist. Nous allons voir comment il se comporte quand on place un échelon de tension sur son entrée. Par échelon de tension, on veut dire que l'on place une tension finie sur son entrée, durant un temps très faible, trop faible pour être considéré comme un signal d'entrée clair. Si le circuit est stable, la sortie du circuit va dépasser zéro durant un certain temps, avant de diminuer et de repasser à 0. La réduction de la tension de sortie peut être progressive, ou se faire par oscillations progressives, mais celles-ci sont amorties. Si le circuit instable, la sortie du circuit peut soit osciller de manière périodique, soit s’emballer et diverger totalement. Ci-dessous, on voit ce qui se passe suivant la valeur du facteur de rétroaction. Si il reste supérieur à -1, le circuit reste stable suite à un échelon de tension. Si il passe par -1, la sortie du circuit se met à osciller périodiquement. Et enfin, si jamais il devient inférieur à -1, la sortie du circuit diverge totalement.

Les quatre topologies des circuits à rétroaction à amplificateurs opérationnels

modifierDans ce qui précède, nous avons parlé de la rétroaction dans le cas général. Tout ce que l'on a dit marche pour beaucoup de choses, en électronique, mais aussi en mécanique, en électromécanique, en hydraulique, voire en dehors de l’ingénierie. Nous avons abordé la rétroaction dans le cadre général de la théorie du contrôle des systèmes dynamiques. Il est maintenant temps d'aborder des connaissances plus ancrées dans l'électronique.

Montage en série et en shunt de l'AOP central et du circuit de rétroaction

modifier

Dans un circuit à rétroaction électronique, on trouve un AOP central bouclé à un circuit de rétroaction. Les deux, l'AOP central et le circuit de rétroaction, sont des quadripôles, à savoir des circuits qui ont quatre bornes. Deux de ces bornes sont des bornes d'entrée, sur lesquelles on peut placer une tension ou un courant, alors que les deux autres fournissent la sortie. En théorie, un quadripôle (idéal ou réel) a pour circuit équivalent les deux circuits ci-contre.

Suivant que l'on mette une tension ou un courant sur l'entrée, on dit que le circuit est en série ou en shunt. Dans le cas en série, on place une tension sur l'entrée. Dans le cas qui nous intéresse, on place la tension d'entrée sur une borne, alors que l'autre reçoit la tension fournie par le circuit de rétroaction. En faisant cela, on est certain que c'est la différence entre ces deux tensions qui est envoyée en entrée de l'AOP. Dans le cas en shunt, on place des courants sur l'entrée. Le courant sur la première borne est le courant du signal d'entrée, celui sur la seconde borne est fourni par le circuit de rétroaction.

Il est possible de faire la même chose, mais pour le circuit de rétroaction. Ce faisant, on peut se retrouver avec quatre possibilités :

- Un shunt sur l'entrée de l'AOP central et du circuit de rétroaction.

- Une série sur l'entrée de l'AOP central et du circuit de rétroaction.

- Un shunt sur l'entrée de l'AOP central et une série sur l'entrée du circuit de rétroaction.

- Une série sur l'entrée de l'AOP central et un shunt sur l'entrée du circuit de rétroaction.

Les explications précédentes peuvent sembler très techniques, en raison du jargon utilisé. Pour le dire autrement, le circuit à rétroaction peut prendre en entrée soit un courant, soit une tension. Et c'est la même chose pour ce qui est fourni en sortie du circuit : c'est soit une tension, soit un courant. Ces quatre possibilités correspondent aux cas suivants :

- L'amplificateur en tension, aussi appelé cas série-shunt, où le circuit prend en entrée une tension et fournit en sortie une tension.

- L'amplificateur en courant, aussi appelé cas shunt-série, où le circuit prend en entrée un courant et fournit en sortie un courant.

- L'amplificateur en transimpédance, aussi appelé cas série-série, où le circuit prend en entrée un courant et fournit en sortie une tension.

- L'amplificateur en transconductance, aussi appelé cas shunt-shunt, où le circuit prend en entrée une tension et fournit en sortie un courant.

Pour résumer, il y a quatre façons de relier entre eux deux quadripôles, qui sont illustrées ci-dessous. Elles correspondent respectivement à l'amplificateur en tension (droite, haut), à l’amplificateur en courant (gauche, bas), à l'amplificateur en transconductance (droite, bas) et l'amplificateur en transimpédance (gauche, haut).

Le montage série-shunt

modifierCommençons par étudier l'amplificateur en tension, le montage série-shunt. Nous allons voir que l'amplificateur en tension est censé avoir une résistance d'entrée forte, alors que sa résistance de sortie doit être la plus faible possible. Et l'usage de la rétroaction permet justement de réduire la résistance de sortie, tout en augmentant la résistance d'entrée.

Pour commencer, nous allons préciser qu'il faut faire la distinction entre la tension et la tension : la première est celle envoyée en entrée du circuit, alors que la seconde est celle en entrée de l'AOP. Pareil pour les courants d'entrée : il y en a deux, que nous noterons et , qui correspondent aux courants d'entrée du circuit et de l'AOP. Même chose pour les résistances d'entrée du circuit et de l'AOP qui sont respectivement notées et .

Dans ce qui suit, nous supposons que l'AOP est un quadripôle réel, alors que le circuit de rétroaction est un quadripôle idéal.

La résistance d'entrée du montage

modifierDans ce qui suit, nous supposons que l'AOP central est un quadripôle réel, avec une résistance d'entrée et une résistance de sortie . Par définition, cette résistance est définie par le rapport entre la tension en entrée de l'AOP et le courant d'entrée, par la relation :

Maintenant, calculons la résistance d'entrée du circuit complet, pas celle de l'AOP, mais celle du circuit complet. Elle est égale, par définition, au rapport entre la tension d'entrée et le courant d'entrée. Si l'on suppose que le circuit de rétroaction est un quadripôle idéal, alors le courant d'entrée est égal au courant d'entrée de l'AOP (il n'y a pas d'autre résistance sur l'entrée du circuit). Dans ce cas, la résistance d'entrée du circuit vaut :

On combine les deux équations précédentes :

Maintenant, on applique la formule :

On voit que ce montage augmente la résistance d'entrée.

La résistance de sortie du montage

modifierMaintenant, étudions la résistance de sortie du montage, et formulons-la à partir de la résistance d'entrée de l'AOP. Nous supposons que l'AOP est un quadripôle réel, alors que le circuit de rétroaction est un quadripôle idéal. L'AOP est composé d'une résistance en série avec un générateur de tension. Le générateur de tension en question fournit une tension égale à :

Si on met la sortie en court-circuit, la tension de sortie est nulle. La tension de rétroaction s'annule elle aussi, en conséquence. La tension d'entrée de l'AOP est donc la tension d'entrée du circuit, ce qui donne :

De plus, le courant de sortie du circuit est égal au courant de sortie de l'AOP. On a donc :

La résistance d'entrée du circuit est égale, par définition, à :

En combinant avec les équations précédentes, on trouve :

On voit que le montage réduit la résistance d'entrée.

Les montages à amplificateurs opérationnels

Les AOP sont rarement utilisés seuls, mais sont souvent utilisés dans des circuits qui combinent un AOP avec des résistances, des bobines, des condensateurs, ou d'autres composants passifs. Dans presque tous les cas, la sortie de l'AOP est reliée à une entrée, ce qui porte le nom de rétroaction. On a alors deux cas : soit l'entrée , soit la . Dans le premier cas, la rétroaction est dite positive, alors qu'elle est dite négative pour le second cas. Les deux situations sont très différentes et l'AOP fonctionne dans deux modes différent selon que la rétroaction est positive ou négative.

- Avec une rétroaction négative, une augmentation de la tension de sortie réduit la différence des entrées, ce qui tend à réduire la tension de sortie. La tension tend à se stabiliser à une valeur précise, d'équilibre. L'AOP est alors dit en mode linéaire, ce qui trahit le fait que la tension de sortie ne sature pas (du moins, pas systématiquement).

- Avec une rétroaction positive, une augmentation de la tension de sortie augmente la différence entre entrée, ce qui augmente encore la tension de sortie et rebelote. La tension augmente ou baisse alors jusqu’à ce qu'elle arrive à la tension de sortie maximale/minimale.

Les montages en mode linéaire (rétroaction négative)

modifierDans ce chapitre, nous allons voir les montages les plus utilisés, en supposant l'AOP idéal. Pour rappel, un AOP parfait respecte les hypothèses suivantes :

- Il n'a pas de courants d'entrée : .

- Son gain différentiel est infini : .

- On néglige les tensions d'offset et le gain en mode commun, ce qui donne : .

En combinant les deux expressions, et en supposant le mode linéaire (contre-réaction négative), on a :

Les deux tensions d'entrée sont donc égales, sous condition qu'il y ait une contre-réaction sur l'entrée . Intuitivement, on peut interpréter ce résultat comme suit.

Pour commencer, étudions le cas où l'AOP a un gain égal à 1. Supposons que les deux tensions d'entrée soient égales : la sortie est alors égale à 0. Maintenant, imaginons que la tension augmente : cela entraine l'apparition d'une tension différentielle et la tension de sortie prend la même valeur (si le gain est de 1). Cette tension différentielle est envoyée sur l'entrée par l'intermédiaire de la contre-réaction : augmente et les augmentations de et se compensent exactement (dans le cas où le gain est de 1).

Si l'AOP a un gain différent de 1, le principe reste valable, même si le déroulement des faits est plus compliqué. On retrouve la même logique qui veut que si augmente, alors fait de même. Par contre, les deux tensions ne se compensent pas exactement du premier coup : à la place, on voit apparaitre une nouvelle tension différentielle, qui modifie elle aussi la tension et ainsi de suite. Le circuit évolue donc continuellement, mais finir par atteindre un état d'équilibre au bout d'un temps assez court. Et à l'équilibre, les augmentations de et se compensent parfaitement et les tensions d'entrée sont égales.

Le montage suiveur

modifier

Le montage le plus simple à étudier est le montage suiveur, illustré ci-contre. Il se limite à une contre-réaction négative, à savoir une liaison de la sortie sur l'entrée .

En appliquant la loi des mailles, on trouve :

- , avec la différence de tension entre et .

Vu que cette dernière vaut zéro, on a :

En clair, ce montage reproduit la tension d'entrée sur sa sortie.

|

Démonstration |

|

On peut aussi analyser ce circuit en utilisant les équations vues au chapitre précédent. Rappelons que l'on a vu que la transmittance d'un circuit à rétroaction négative est donnée par la formule suivante, avec le gain de l'AOP et le gain du circuit de rétroaction. Dans le montage suiveur, le circuit de rétroaction est un simple, ce qui fait que sa transmittance est de 1 (le signal d'entrée est égal au signal de sortie). On a donc : |

Le montage non-inverseur

modifier

Le montage non-inverseur est illustré dans le schéma ci-contre.

Rappelons que le courant d'entrée d'un AOP parfait est nul. Avec cette hypothèse, on peut calculer la tension par un simple pont diviseur de tension :

On a aussi, de par les hypothèses de l'AOP parfait :

Ce qui donne :

Multiplions par :

Divisons par

Simplifions la fraction :

- Le montage suiveur peut être vu comme un cas particulier du montage non-inverseur, pour lequel on aurait : et . Les calculs redonnent bien ce qu'on a établi pour le montage suiveur, à savoir :

- :

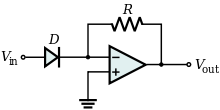

Le montage convertisseur courant-tension

modifier

La particularité de ce montage est que l'entrée ne reçoit pas une tension, mais un courant d'entrée . Vu que l'AOP n'absorbe pas de courant (ses courants sur les entrées sont nuls), tout le courant passe dans la résistance.

L'entrée est reliée à la masse, ce qui fait que . Si l'AOP est parfait, on a donc :

La loi des mailles donne alors :

- , avec la tension aux bornes de la résistance R.

Dit autrement, on a :

Ce montage convertit donc le courant d'entrée en une tension, par l'intermédiaire de la résistance R.

Le montage inverseur

modifier

Le montage illustré ci-contre est appelée le montage inverseur. Ce nom vient de ce que fait ce montage. Sa tension de sortie est l'inverse (en réalité l'opposée) de la tension d'entrée, pondérée par un coefficient lié aux résistances.

La démonstration la plus simple utilise les approximations du début du chapitre. Vu que les courants d'entrée de l'AOP sont nuls, le circuit est alors composé de deux résistances en séries, alimentées aux deux bouts par une tension : d'un côté, de l'autre. C'est la situation parfaite pour utiliser le théorème de superposition (aussi appelé théorème de Millmann). Si on ne garde que et qu'on met à 0, le circuit devient un simple pont diviseur. Idem si l'on met à 0 en conservant . La tension d'entrée est la somme de ces deux ponts diviseurs, ce qui donne :

Mais vu que l'entrée est connectée à la masse, on a :

Ce qui donne :

On multiplie par : des deux côtés :

On divise par des deux côtés :

- }}

Il existe aussi un autre moyen de faire la démonstration, sans faire d'approximations simplificatrices.

|

Démonstration |

|

La tension de sortie de l'AOP est donnée, par définition, par la formule suivante : Le schéma montre que l'entrée est reliée à la masse et vaut donc 0, ce qui simplifie la formule précédente en : La tension provient de la somme de deux ponts diviseur entre la tension d'entrée et de sortie, ce qui donne : On combine alors avec la formule qui donne la tension : On développe : On réorganise les termes : On factorise le terme de gauche : On met au même dénominateur dans le terme de gauche : On simplifie : On isole alors : On simplifie : Si on suppose que est très grand par rapport aux valeurs des résistances, on a alors : |

On peut aussi reformuler ce développement comme suit. On peut voir ce montage inverseur comme une amélioration du montage précédent, auquel on aurait rajouté une résistance sur l'entrée. Cette résistance convertit la tension d'entrée en un courant, qui est convertit par le reste du montage en une tension. Cela fonctionne parce que la tension sur l'entrée est nulle, ce qui fait que schéma équivalent du montage est celui illustré ci-contre. Vu que le courant d'entrée de l'AOP est nul, tout le courant passe dans les deux résistances. On a donc :

Quelques manipulations algébriques redonnent bien l'équation précédente.

On peut reformuler cette équation de manière à obtenir le gain de l'amplificateur :

On voit que le gain obtenu n'est pas égal au gain différentiel (ou au gain en mode commun). D'un côté le gain différentiel est supposé infini, de l'autre le gain réel dépend de la valeur des résistances. Cela nous amène à faire la distinction entre deux gains : le gain différentiel vu précédemment, et le gain obtenu avec les calculs de cette section. Le gain différentiel est une propriété de l'AOP quand celui-ci n'a pas de rétroaction, ce qui lui vaut son appellation de gain en boucle ouverte. Par contre, le gain mesuré dans un montage avec une rétroaction est différent. Ce gain est appelé gain en boucle fermée, pour signifier qu'il implique une boucle de rétroaction (négative).

Le montage sommateur-inverseur

modifier

Le montage sommateur-inverseur est une amélioration du montage précédent, la différence étant que l'on a plusieurs tensions/résistances reliées à l'entrée . Le montage additionne les tensions placées sur cette entrée et fournit en sortie l'inverse de cette somme. Pour le démontrer, repartons du second développement du montage inverseur. On sait que la tension est nulle.

Pour le courant qui circule dans la résistance , on a :

On peut aussi calculer la somme des courants qui circulent dans chaque résistance d'entrée, ce qui donne :

Vu que le courant d'entrée de l'AOP est nul, les deux courants sont égaux :

En multipliant par , on a :

Ce circuit additionne donc les tensions pondérées par chaque résistance.

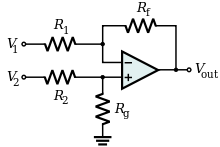

Le montage amplificateur différentiel

modifier

Le montage en amplificateur différentiel est le même que le montage inverseur, si ce n'est qu'on a ajouté un pont diviseur sur la tension d'entrée.

La tension se calcule exactement comme avec le montage inverseur (théorème de Millmann/superposition), ce qui donne :

La tension se calcule avec un pont diviseur de tension :

Les deux tensions sont égales, par les hypothèses de l'AOP parfait :

On soustrait : des deux côtés :

On divise des deux côtés par : :

On développe :

On simplifie et on réarrange les termes :

Deux cas particuliers sont intéressants à étudier :

- Quand et , on a :

- Quand et , on obtient le montage soustracteur :

Le montage amplificateur d'instrumentation

modifierLe montage amplificateur d'instrumentation est une amélioration de l'amplificateur différentiel. Il suffit d'ajouter deux suiveurs sur les deux entrées du circuit pour obtenir un amplificateur d'instrumentation. Ce faisant, on est certain que les courants d'entrée de l'AOP (qui sont non-nuls pour un AOP réel) ne perturbent pas le fonctionnement du circuit.

Sur certains montages, on ajoute quelques résistances : une dans chaque boucle du suiveur, et une autre pour relier les deux boucles, afin d'améliorer le fonctionnement du circuit.

Le montage intégrateur

modifier

Le montage intégrateur ressemble au montage inverseur, si ce n'est qu'on a remplacé une résistance par un condensateur. Le montage est illustré ci-contre.

Si on suppose l'AOP parfait, il n'y a pas de courants d'entrée.

Aux bornes de la résistance, on a :

Au bornes du condensateur, on a :

Le courant circule dans le circuit série formé par la résistance et le condensateur, ce qui fait qu'il est identique en tout point du circuit. Les deux courants des équations précédentes sont égaux, ce qui donne :

Divisons par C :

Intégrons pour trouver :

Simplifions :

Ce circuit calcule donc l'intégrale de la tension d'entrée au cours du temps (pondérée par le produit RC). D'où son nom de montage intégrateur.

Le montage dérivateur

modifier

Si on inverse de place la résistance et le condensateur, le comportement du montage est changé du tout au tout. De montage intégrateur, il passe à un montage dérivateur, qui calcule la dérivée de la tension d'entrée. Pour le démontrer, il faut refaire les développements de la section précédente. La seule différence est que la tension d'entrée et de sortie seront inversées. Évidemment, on suppose l'AOP parfait, ce qui fait qu'il n'y a pas de courants d'entrée.

Aux bornes de la résistance, on a :

Au bornes du condensateur, on a :

Les deux courants précédents sont égaux, ce qui donne :

Multiplions par R :

Ce circuit calcule donc la dérivée de la tension d'entrée au cours du temps (pondérée par le produit RC).

Le montage exponentiel

modifier

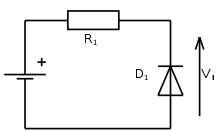

Le montage exponentiel est une amélioration du montage convertisseur courant-tension : on a rajouté une diode sur l'entrée du montage. Et cette fois-ci, on envoie une tension sur l'entrée du montage, et non un courant.

La diode ne change pas grand chose au fonctionnement du montage, vu que la chute de tension à ses bornes est négligeable. On a toujours :

Par contre, on peut le courant qui parcourt le circuit est le courant fournit par la diode (en fonction de la tension d'entrée). Celui-ci vaut, d'après l'équation de Schokley vue il y a quelques chapitres :

En combinant les deux expressions précédentes, on a :

En clair, ce montage calcule l'exponentielle de la tension d'entrée, à un coefficient de proportionnalité près.

- En réalité, l'équation de Schokley d'une diode n'est pas , mais : . Cela modifie quelque peu les calculs, ce qui donne l'équation suivante :

Le montage logarithmique

modifier

Le montage logarithmique est une variante du montage précédent, dans lequel la diode et la résistance échangent leurs places.

Ici, la diode est alimentée par la tension , ce qui fait que le courant qui traverse le circuit est de :

On a toujours , ce qui donne :

En combinant les deux expressions précédentes, on a :

On peut reformuler l'expression comme suit :

Prenons le logarithme des deux côtés :

Multiplions par la tension de seuil de la diode :

En clair, ce montage calcule le logarithme de la tension d'entrée, à un coefficient de proportionnalité près.

- En réalité, l'équation de Schokley d'une diode n'est pas , mais : . Cela modifie quelque peu les calculs, ce qui donne l'équation suivante :

Nous en aurons besoin dans la section suivante.

Le montage multiplieur

modifierLe montage multiplieur fournit en sortie le produit des deux tensions d'entrée. Il est composé avec l'aide des circuits exponentiels, logarithmiques, inverseurs et sommateurs vus plus haut. L'idée qui se cache derrière ce circuit est redoutablement simple, pour qui connait les propriétés des logarithmes. On sait que le logarithme d'un produit est égal à la somme des logarithmes. Cette propriété a durant longtemps été exploitée pour faire des multiplications à la main, pour des opérandes étaient assez grandes. Il suffit de réutiliser ce principe ici : on prend les logarithmes de chaque entrée, on les additionne, puis on prend l'exponentielle du résultat pour obtenir le résultat final. En clair, on a un montage logarithmique sur chaque entrée, un circuit sommateur, et enfin un montage exponentiel. Le circuit final est illustré ci-dessous.

On peut créer le circuit sommateur de plusieurs manières. La méthode la plus évidente est d'utiliser un montage inverseur-sommateur, suivi par un montage inverseur (pour compenser l'inversion réalisée par le montage inverseur-sommateur). Mais il existe une autre solution, bien plus élégante. Avec elle, les sorties des montages logarithmiques sont placées en série avec une résistance, pour transformer la tension (le logarithme), en un courant proportionnel. Puis, les deux fils sont reliés/fusionnés : la loi des nœuds fait que les deux courants sont additionnés. Enfin, on fait passer le courant obtenu (la somme des courants logarithmiques) dans un montage de conversion courant-tension. Le circuit total, montages exponentiels et logarithmiques inclus, est celui-ci :

En réalité, ce montage ne marche pas parfaitement, pour une raison simple : le montage logarithmique ne calcule pas exactement le logarithme, mais fait le calcul suivant :

La somme des deux logarithmes donne donc :

En appliquant la règle on a :

En appliquant le montage exponentiel, on trouve :

Ce qui se simplifie en :

Il faut donc ajouter les deux tensions d'entrée au résultat pour obtenir le bon résultat. Il suffit d'ajouter un montage sommateur, ce qui donne le circuit suivant :

Les montages en mode comparateur (rétroaction positive ou absence de rétroaction)

modifierLes montages précédents utilisent tous une contre-réaction négative, à savoir qu'ils relient la sortie à l'entrée . Cette contre-réaction négative fait fonctionner l'AOP dans le régime linéaire et la sortie tend à être stable autour d'une valeur d'équilibre. Mais il est aussi possible de relier la sortie à l'entrée positive . Dans ce cas, le circuit fonctionne tout autrement. Le circuit fonctionne alors en mode de saturation, à savoir que sa sortie est égale à la valeur maximale ou minimale que peut fournir l'AOP. Les circuits qui utilisent cette propriété sont généralement des comparateurs de tension, qui comparent les deux tensions d'entrée entre elles, ou qui comparent une tension d'entrée à un seuil prédéfini. Dans cette section, nous allons voir les montages qui utilisent une contre-réaction positive, et notamment les comparateurs.

Le comparateur à un seuil (absence de rétroaction)

modifierPour commencer cette section, je me dois de faire une digression sur l'AOP en mode de saturation. Un AOP parfait est, par définition, un comparateur. En effet, son comportement en régime de saturation est défini par les deux équations suivantes :

- Si :

- Si :

Un simple AOP, sans contre-réaction, permet de réaliser un circuit qui compare la tension d'entrée à un seuil. Si la tension est sous le seuil, . Mais si la tension d'entrée dépasse ce seuil : . Pour cela, il suffit de placer la tension de seuil sur l'entrée et de mettre la tension d'entrée sur l'entrée . Ce circuit est appelé un comparateur à un seuil.

Le schéma ci-dessous illustre un comparateur à un seuil qui compare la tension d'entrée au seuil .

Le circuit comparateur à deux seuils (trigger de Schmitt)

modifierLe circuit précédent n'utilise pas de rétroaction. Les circuits que nous allons voir dans cette section utilisent une rétroaction positive, qui garantit qu'ils fonctionnent en saturation. Pour comprendre pourquoi l'AOP fonctionne en saturation, étudions ce qui se passe quand la tension différentielle est positive. En clair la tension d'entrée du circuit est telle que la sortie de l'AOP est positive. La tension de sortie positive est alors renvoyée en entrée, où elle s'ajoute à la tension d'entrée préexistante. La tension d'entrée finale augmente donc, ce qui fait encore augmenter la tension de sortie de l'AOP. Et la boucle recommence, la tension de sortie augmentant jusqu’à ce que l'AOP atteigne sa tension maximale. Pour le cas où la tension d'entrée fait que la tension d'entrée est négative, c'est le même raisonnement, si ce n'est que la tension de sortie sera négative. On voit donc que la rétroaction fait que le processus 'emballe : de petites différences d'entrées s'amplifient de plus en plus, jusqu’à ce que l'AOP atteigne sa tension maximale ou minimale.

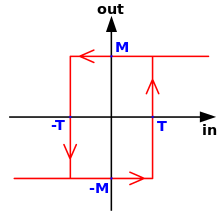

Le comparateur à deux seuils est un comparateur un peu spécial. Il dispose non pas d'un seuil, mais de deux seuils de basculement. Lorsque le premier seuil est franchit, le circuit voit sa sortie passer de -VCC à +VCC. Le second seuil est pour l'opération inverse : quand la tension d'entrée descend en-dessous de ce second seuil, la sortie passe de +VCC à -VCC. Le premier seuil (passage de -VCC à +VCC) est appelé le seuil positif, alors que l'autre est appelé le seuil négatif. La raison est, pour la majorité des montages, ces deux seuils ont la même valeur absolue, mais des signes différents.

Le fonctionnement de ce circuit est résumé dans le schéma ci-contre. Ce schéma est appelé une courbe d'Hystérésis. L'interprétation de cette courbe est la suivante. Supposons que la tension d'entrée soit comprise au-delà du seuil T : la sortie est donc égale à +VCC. Imaginons maintenant qu'elle descende en-dessous du seuil T, mais reste supérieure à -T. Dans ce cas, la sortie restera à +VCC. Ce n'est que quand elle descendra sous le seuil - T que la sortie basculera à -VCC. Ensuite, imaginons que l'entrée, initialement sous le seuil -T, dépasse ce seuil et augmente progressivement. Rien ne se passe tant que l'entrée n'a pas dépassé le seuil de basculement T et la sortie reste à -VCC. Ce n'est qu'une fois le seuil T dépassé que la sortie bascule à +VCC. Les flèches indiquent comment interpréter ces basculements et les hausses/baisses de tension de sortie selon l'entrée.

Pour résumer :

- Si l'entrée est en-dessous du seuil négatif -T, la sortie est à -VCC.

- Si l'entrée est au-dessus du seuil positif +T, la sortie est à +VCC.

- Entre les deux, la sortie garde sa valeur précédente, qui est de +VCC ou de -VCC selon l'histoire du circuit.

Le comparateur à deux seuils inverseur

modifier

Il existe deux circuits comparateurs à deux seuils, qui ressemblent aux circuits inverseur et non-inverseur obtenus avec contre-réaction négative. La seule différence est que la contre-réaction est ici placée sur la borne et non . Le circuit inverseur est montré ci-contre.

On voit immédiatement que la tension est obtenue par un pont diviseur de tension, ce qui donne :

Vu que l'AOP est en mode de saturation, peut prendre deux valeurs possibles : +VCC et -VCC. En injectant ces deux valeurs dans l'équation précédente, on trouve l'expression des deux seuils :

- : seuil positif.

- : seuil négatif.

Le comparateur à deux seuils non-inverseur

modifier

Passons maintenant au circuit non-inverseur.

Cette fois-ci, on doit utiliser le théorème de superposition (ou de Milmann, c'est selon) pour analyser ce circuit (comme on l'avait fait avec le montage non-inverseur). On a alors :

Vu que l'AOP est en mode de saturation, peut prendre deux valeurs possibles : +VCC et -VCC. En injectant ces deux valeurs dans l'équation précédente, on trouve a :

Reste alors à trouver la tension qui annule la tension différentielle (et donc la tension ), pour trouver les tensions de seuil. Quelques manipulations algébriques triviales donnent alors :

- : seuil positif.

- : seuil positif.

Les filtres électriques

Les filtres électriques sont des quadripôles, qui prennent en entrée une tension en fournissent en sortie une version atténuée de la tension d'entrée. Ceux-ci sont des composants qui atténuent les signaux dans une certaine gamme de fréquence. Ils vont par exemple laisser passer les signaux à basse fréquence, mais filtrer les hautes fréquences, ou inversement. Plus précisément, les filtres vont modifier l'ensemble des sinusoïdes qui leur parviennent. Si on leur envoie un signal (une tension ou courant quelconque) sur leur entrée, ils vont traiter ce signal et fournir une version traitée sur leur sortie. Pour donner quelques exemples, les circuits RC, RL, et RLC sont des filtres parmi tant d'autres. On a vu dans le chapitre sur l'impédance que ceux-ci fournissent une tension de sortie (aux bornes du condensateur ou de la bobine), quand on leur fournit une tension d'entrée. Leur étude dans le chapitre sur l'impédance a servi en quelque sorte d'introduction à l'étude des filtres électriques, là où ce chapitre porte sur l'étude des filtres de manière plus générale.

Il existe un grand nombre de filtres électroniques, qui ont chacun leurs avantages et inconvénients. Les critères utilisés pour classer les filtres sont assez nombreux : on peut les classer en fonction de leur bande passante, de leur ordre, de leur caractère actif/passif ou de certaines propriétés mathématiques. Dans ce qui va suivre, nous allons voir quelques classifications assez courantes des filtres. Nous allons d'abord voir la différence entre les filtres passe-haut, passe-bas, passe-bande et coupe-bande, qui ont chacun un comportement en fréquence bien précise. Puis, nous enchaînerons avec une classification plus élaborée qui distingue les filtres de Bessel, Butterworth, Tchebychev et Legendre.

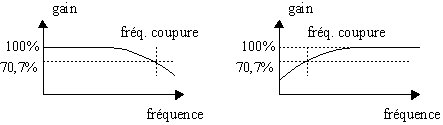

La réponse en fréquence d'un filtre électronique

modifierLorsqu'on envoie un signal sinusoïdal en entrée d'un filtre, on retrouve en sortie un signal sinusoïdal d'une amplitude plus faible qu'à l'entrée. En quelque sorte, les filtres sont l'inverse d'un amplificateur : au lieu d'amplifier un signal, ils l'atténuent. Cette atténuation dépend de la fréquence du signal d'entrée : elle est minimale, voire nulle pour certaines fréquences, plus importante pour d'autres. Pour certaines fréquences, le signal de sortie est si faible qu'il est négligeable : la fréquence qui correspond est alors filtrée, atténuée, éliminée du signal original.

La relation atténuation-fréquence

modifierSi on étudie la variation du gain en fonction des fréquences, on peut tomber sur plusieurs possibilités. Les quatre principales sont les suivantes :

- Le gain augmente avec la fréquence. Le filtre atténue les basses fréquences, mais laisse passer les hautes fréquences. Le filtre est dit un filtre passe-haut.

- Le gain diminue avec la fréquence. Le filtre laisse passer les basses fréquences, mais atténue les hautes fréquences. Le filtre est dit un filtre passe-bas.

- Le gain augmente jusqu'à une fréquence maximale avant de diminuer. Dit autrement, le gain est minimal pour les hautes et basses fréquences, maximal pour un intervalle bien précis. Le filtre laisse passer les fréquences contenues dans un intervalle, mais atténue les fréquences situées en dehors de celui-ci. C'est le comportement d'un filtre passe-bande.

- Le gain est maximal pour les hautes et basses fréquences, mais minimal dans un intervalle précis. Le gain diminue jusqu'à une fréquence maximale avant de remonter. Le filtre laisse passer les fréquences situées en dehors d'un intervalle, mais atténue les fréquences situées dans l'intervalle. C'est le comportement d'un filtre coupe-bande.

Certains filtres ont un comportement plus complexe et fonctionnent comme la superposition de filtres plus simples. Par exemple, certains filtres se comportent comme un filtre passe-bas aux basses fréquences, mais laissent passer une bande de fréquence dans certaines hautes fréquences. Et les exemples de ce type sont nombreux.

On considère arbitrairement qu'un filtre ne laisse pas passer les fréquences dont l’atténuation est de moitié, les autres n'étant pas filtrées. Si on fait les calculs, cela correspond à un gain diminué de 3 dB. La fréquence qui correspond à une atténuation réduite de moitié, c'est à dire où la puissance dissipée par le filtre est la moitié de celle fournie en entrée, est appelée la fréquence de coupure. En clair, le signal voit son amplitude en tension ou en courant divisée par , soit égale à 70,7% du signal originel. Une illustration est donnée ci-dessous pour un filtre passe-bas et un filtre passe-haut.

Pour la plupart des filtres, il existe entre une et deux fréquences de coupures, qui délimitent une bande de fréquences qui ne sont que peu filtrées. La largeur de cet intervalle est appelée la bande passante du filtre.

La relation déphasage-fréquence

modifierSi le gain varie avec la fréquence, il en est de même pour la phase. Les signaux envoyés à un filtre en ressortent avec un déphasage par rapport à l'entrée. Qui plus est, ce décalage est généralement dépendant de la fréquence, la relation exacte variant selon le filtre considéré. L'origine de ce déphasage est que les signaux mettent un certain temps pour parcourir le filtre, pour faire le chemin de l'entrée vers la sortie, ce temps de parcours se traduisant par déphasage entre entrée et sortie. Généralement, plus un filtre contient de composants enchaînés les uns à la suite des autres, plus ce déphasage est important.

Tous les types de filtres introduisent un décalage constant pour toutes les fréquences. Attention : par décalage constant, on veut dire que le temps de parcours du filtre est identique pour toutes les fréquences. Si on regarde le déphasage, cela se traduit par un déphasage proportionnel à la fréquence. Par exemple, si le déphasage est de 20° à une fréquence de 5 KHz, alors il est de 40° pour 10 KHz, de 80° pour 20 KHz, de 800° pour 2000 KHz, etc. Ce temps de décalage est appelé le retard de groupe, nom qui traduit le fait que toutes les fréquences sont touchées de la même manière. Un signal envoyé sur un filtre ne sera pas modifié par le retard de groupe, vu que toutes les harmoniques du signal seront retardées de la même manière. Il n'implique donc aucune distorsion du signal d'entrée.

Si certains types n'introduisent que ce décalage de groupe, sans autres formes de retard supplémentaires, ce n'est pas le cas pour la majorité des filtres. Divers retards dépendant de la fréquence viennent s'ajouter au retard de groupe et ajoutent un déphasage dépendant de la fréquence. Une conséquence de cette approche se voit quand on envoie des signaux non-sinusoïdaux en entrée de tels filtres. Les diverses harmoniques du signal traversent le filtre à des vitesses différentes et ressortent chacune avec un délai différent de leur voisine. Les harmoniques ont chacune leur propre déphasage, ce qui donne un signal d'entrée déformé. Le résultat est une distorsion du signal, qui est d'autant plus importante que les retards dépendant de la fréquence sont importants.

La transmittance d'un filtre : propriétés mathématiques

modifierDe manière générale, la transmittance d'un filtre s'exprime avec une fraction, composée d'un numérateur et d'un dénominateur (respectivement, la tension d'entrée et de sortie), qui dépendent tous deux de la fréquence de la tension d'entrée.

Le numérateur et le dénominateur sont tous deux des polynômes, dont la fréquence d'entrée est la seule variable. De manière générale, on peut écrire la transmittance de tout filtre de cette manière :

L'ordre d'un filtre

modifierL'exposant le plus élevé dans le dénominateur est appelé l'ordre du filtre. Par exemple, on dira que le filtre est d'ordre 2 si la fréquence est élevée au carré dans le dénominateur, d'ordre 4 si elle est élevée à la puissance 4, etc. Il a un rôle tout particulier à jouer, car elle décrit la sensibilité du filtre à la fréquence. Plus la puissance est élevée, plus le filtre aura un filtrage efficace. Par exemple, pour un filtre passe-bas, l'atténuation sera d'autant plus rapide que l'ordre du filtre est important. Par contre, plus l'ordre d'un filtre est élevé, plus il contient de composants électroniques : il est donc plus complexe, plus difficile à produire, plus coûteux, etc.

Pour un filtre du premier ordre, la transmittance est une équation qui dépend de la fréquence de coupure . Si vous étudiez les formules qui vont suivre, vous verrez qu'elles ressemblent aux formules obtenues pour les filtres RC et RL. Le fait est que les filtres RC et RL sont des filtres du premier ordre.

| Filtre passe-bas | |

|---|---|

| Filtre passe-haut |

La transmittance des filtres du second ordre est une équation quadratique qui contient deux constantes et , dépendantes du circuit, appelées respectivement facteur d'amortissement et facteur de qualité. Le facteur de qualité est défini comme le rapport entre la fréquence propre , celle où le gain est maximal, et la largeur de la bande passante. Le facteur d'amortissement est défini à partir du facteur de qualité, comme étant la moitié de son inverse. On a donc :

| Filtre passe-bas | |

|---|---|

| Filtre passe-haut | |

| Filtre passe-bande | |

| Filtre coupe-bande |

- Si vous étudiez les formules qui vont suivre, vous verrez qu'elles ressemblent aux formules obtenues pour le filtre RLC. Le fait est que le filtre RLC est du second ordre, à savoir que la fréquence est mise au carré dans l'équation de la transmittance.

Les zéros et pôles d'un filtre

modifierOn peut reformuler les formules pour la transmittance en se souvenant que tout polynôme peut être factorisé en utilisant ses racines. Ainsi, tout polynôme de la forme peut se reformuler comme suit : , avec les racines du polynôme. En reformulant ainsi les polynômes de la transmittance, on a :

Les racines du numérateur sont appelées les zéros et les racines du dénominateur sont appelées les pôles. Ce sont des nombres complexes, avec chacun une partie réelle et une partie imaginaire. Il est possible de placer ces pôles et zéros sur un plan complexe, ce qui donne le graphe des pôles d'un filtre. Il est très utilisé pour déterminer si certaines fréquences rendent le filtre instable. En effet, les pôles sont des valeurs pour lesquelles le dénominateur de la transmittance est nul, et où la transmittance est donc infinie. Si un pôle se situe sur la moitié gauche du graphe des pôles, cela n'a pas trop d'importance, vu qu'il s'agit de valeurs que l'on ne peut pas observer en réalité (une partie réelle négative signifie un gain négatif, chose qui n'a pas vraiment de sens). Mais la présence d'un pôle sur la partie droite est plus problématique. Si le pôle se situe sur l'axe des abscisses, la transmittance augmente exponentiellement jusqu'à ce que la fréquence atteigne ce pôle (où elle est alors infinie). Si elle est en dehors, cela signifie que le déphasage et/ou le gain peuvent devenir infinis et donc que le filtre est extrêmement instable.

Certains filtres n'ont pas de zéros du tout, du moins tant que la fréquence reste finie. De tels filtres sont appelés des filtres tous pôles. Pour de tels filtres, la transmittance peut tendre vers zéro, mais seulement quand la fréquence tend elle aussi vers zéro. En clair : on peut avoir . Cette condition à la limite impose qu'au-delà d'une certaine fréquence, la transmittance baisse. En conséquence, de tels filtres sont forcément des filtres de type passe-bas ou passe-bande, mais ne peuvent pas être des filtres passe-haut ou coupe-bande. Vu l'absence de zéros, la fonction de transfert de ces filtres est la suivante :

La décomposition d'un filtre en filtres plus simples

modifierReprenons maintenant à partir de l'expression suivante de la transmittance :

Il est possible de regrouper les termes par groupes de deux, ce qui donne :

En développant chaque produit, on peut réécrire la formule comme suit :

En clair, la transmittance de tout filtre peut s'exprimer comme le produit de termes de la forme , avec P1 et P2 deux polynômes du premier ou du second degré. La traduction en termes électroniques est que tout filtre peut se décomposer en filtres plus simples, du premier ou du second ordre. C'est d'ailleurs souvent ainsi que sont fabriqués les filtres d'un ordre > 2 : ils sont formés par assemblage de filtres du 1er/2nd ordre.

Les types de filtres en fonction de la formule mathématique de leur transmittance

modifier

Suivant les propriétés mathématiques de ces polynômes, on peut distinguer plusieurs types de filtres. Dans cette section, nous allons voir une classification basée sur des propriétés mathématiques précises, qui distingue les filtres de Bessel, Butterworth, Tchebychev et Legendre. Nous utiliserons beaucoup le diagramme gain-fréquence dans ce qui suit, le fameux diagramme de Bode. On verra qu'à l’exception des filtres de Butterworth celui-ci présente des vagues en forme de morceaux de sinusoïdes sur le diagramme gain-fréquence.

| Type de filtre | Caractéristiques |

|---|---|

| Filtre de Bessel | Délai constant en bande passante |

| Filtre de Butterworth | Gain le plus constant possible dans la bande passante |

| Filtre de Tchebychev | Meilleure atténuation en dehors de la bande passante, mais transmittance fluctuante dans la bande passante |